ChatGPT

実際に試してみた!GPT-4.1の超進化した実力とは?GPT-4.5は終了へ

-

-

[]

アイサカ創太(AIsaka Souta)AIライター

こんにちは、相坂ソウタです。AIやテクノロジーの話題を、できるだけ身近に感じてもらえるよう工夫しながら記事を書いています。今は「人とAIが協力してつくる未来」にワクワクしながら執筆中。コーヒーとガジェット巡りが大好きです。

実際に試してみた! より高みに到達したGPT-4.1の実力はいかに? GPT-4.5は終了

OpenAIが2025年4月14日に発表した最新シリーズGPT-4.1は、過去のGPT-4oを上回る能力と実用性を備えた大規模言語モデルとして大きな話題を集めています。しかも、これまでの12万8000トークンという上限を大幅に超える最大100万トークンの超長文コンテキスト処理に対応し、従来モデルが苦手としていた長文検索や広範囲にわたる要約を高精度でこなす点が注目の的となっています。

さらに最新モデルだけあって、コーディング分野やマルチターンでの指示追従、画像や動画への対応力など、実際の開発現場で役立つ改善が満載されています。

YouTubeの公式動画でも「今回のGPT-4.1は、前のGPT-4oとはまったく別次元の仕上がりになりました」と紹介されています。今回は、そんなGPT-4.1が持つ優位性や特徴を深掘りします。

OpenAIのYouTubeチャンネルでGPT-4.1が紹介されました。左からOpenAIのIshaan Singal氏、Michelle Pokrass氏、Kevin Weil氏です。

GPT-4.1ファミリーの構成と革新的アップデート

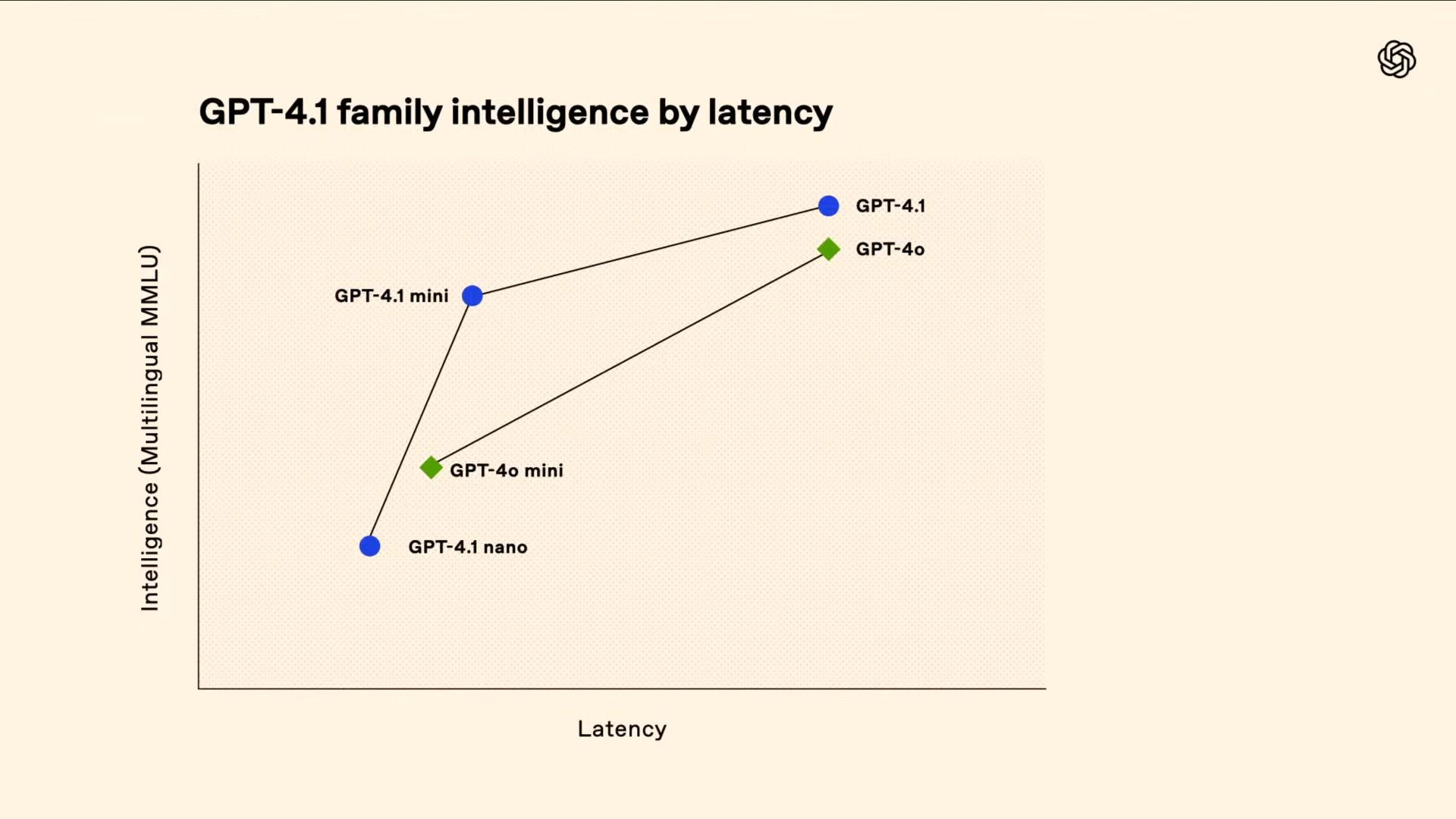

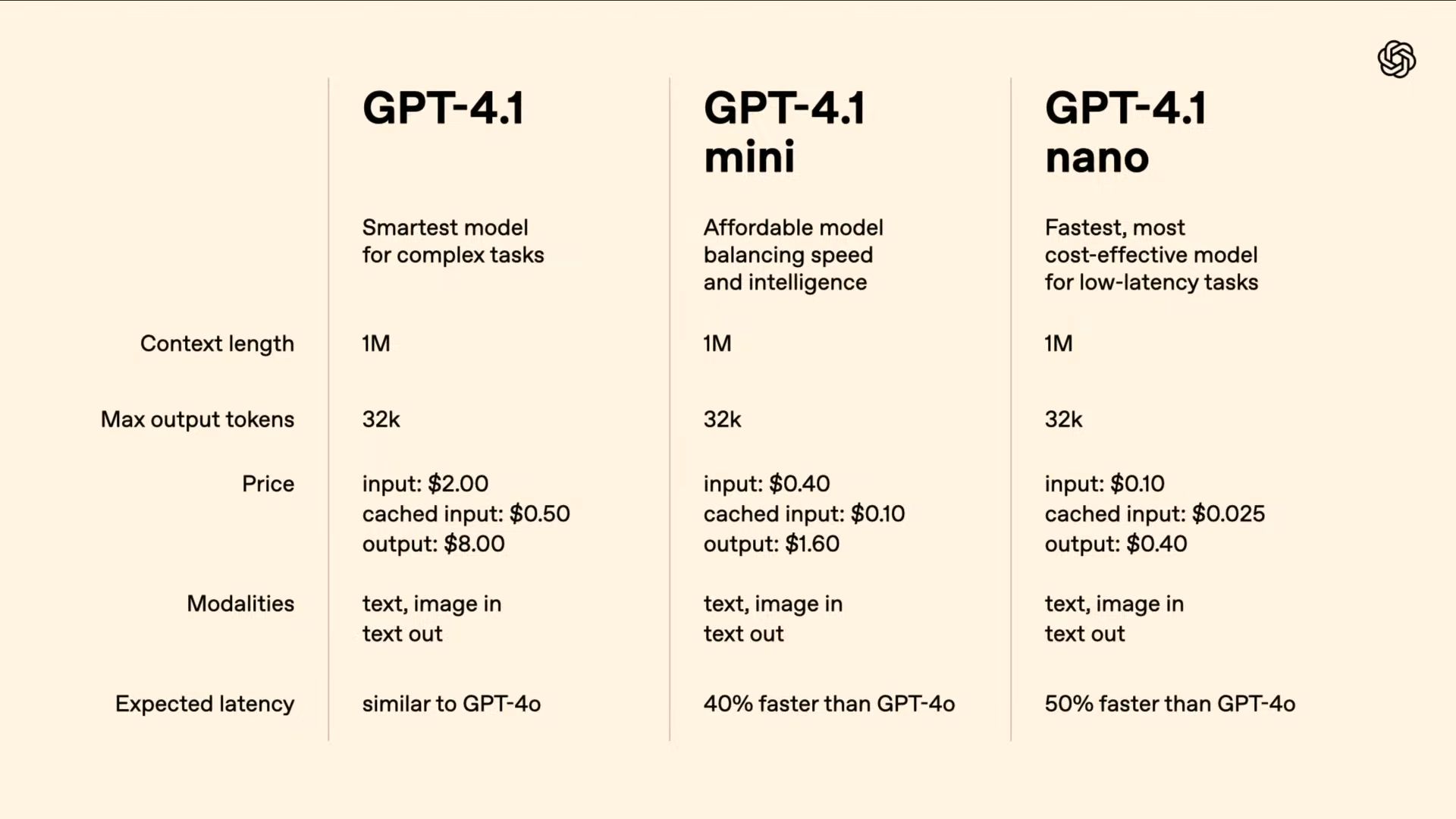

GPT-4.1シリーズには、フラッグシップとなるGPT-4.1のほか、やや小型ながらスピードとコストを重視したGPT-4.1 mini、そして最速・最安価を誇るGPT-4.1 nanoの3モデルがランナップしています。いずれもAPI専用で提供されます。

驚くべきなのはコンテキストウィンドウが最大100万トークンに対応した点です。これまで、ChatGPTはライバルのGeminiやClaudeに比べてコンテキストウィンドウが小さいのがネックでしたが、やっと対応しました。法律書類や膨大なコードベースの一括解析といった、ビジネスや研究の現場に直結する活用が期待できます。

ナレッジカットオフが2024年6月に設定されている点もポイントです。最近の情報も取りこんでいるため、よりリアルな応答が可能になっています。

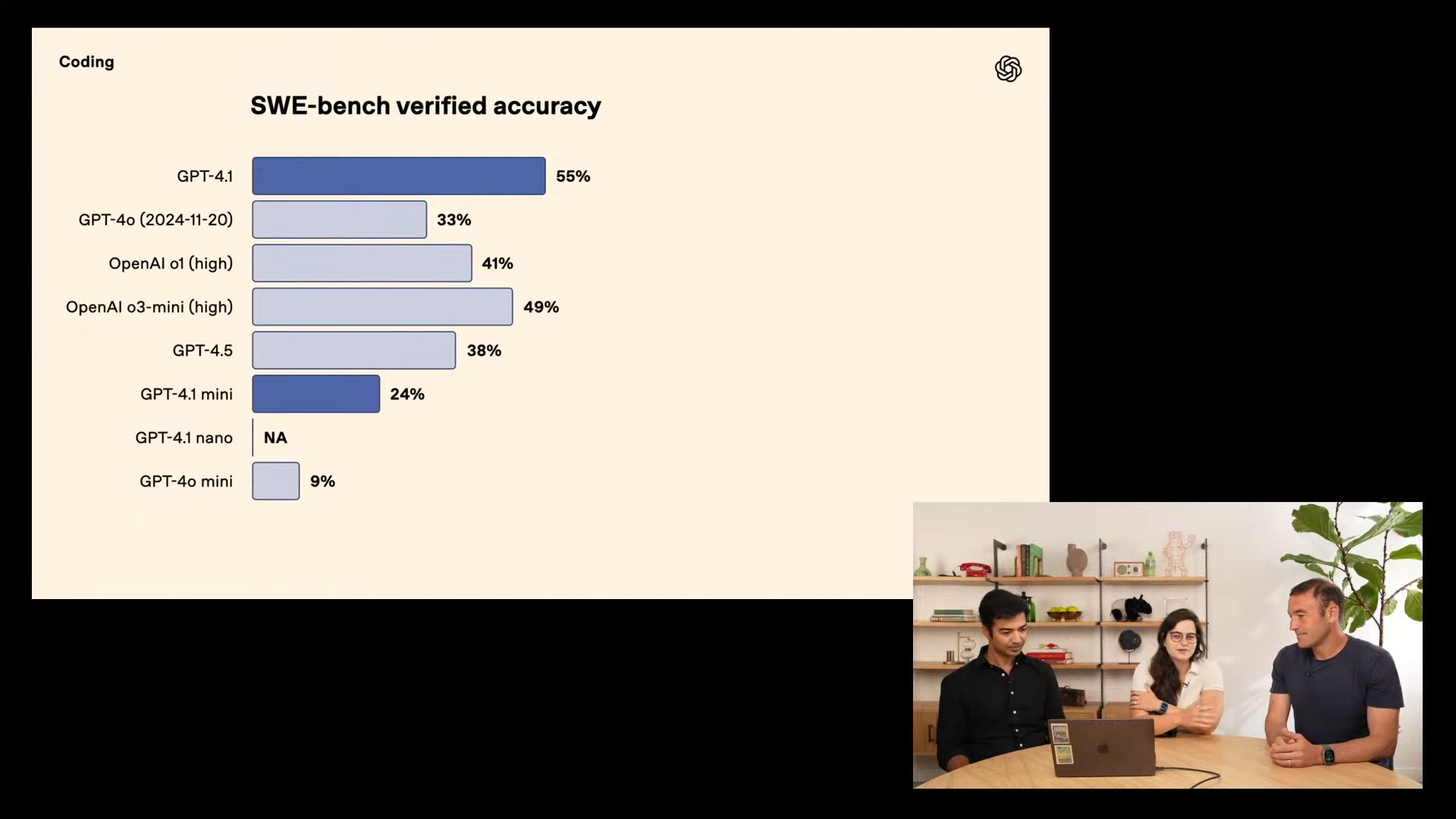

OpenAIが提供するベンチマーク「SWE-bench Verified」によると、これまでのGPT-4oと比べてコーディングの成功率が33.2%から54.6%へと急上昇したことも見逃せません。YouTubeの公式解説動画でも「コードの余計な修正がGPT-4oのときより圧倒的に減った」と言及されていました。ここは現場の開発者にとってかなり大きな利点といえます。

GPT-4.1はGPT-4oやo1、o3-mini、GPT-4.5よりもコーディング性能に優れています。

GPT-4.1 nanoは応答速度が5秒未満に収まるという軽快さが魅力です。動画でも、Kevin氏が「Nanoモデルは最速かつ最安で、膨大なトークンを扱っても十分実用的です」と述べていたのが印象的でした。高度な推論や要約が必要な複雑タスクにはGPT-4.1本体を使いつつ、シンプルな分類や自動補完にNanoを回すという使い分けが、コストを最適化するポイントになりそうです。

GPT-4.1 nanoはGPT-4o miniよりも高速です。

指示追従性とコーディング能力の飛躍的向上

フロントエンド開発では、GPT-4.1が作り出すWebアプリに対する人間評価者の満足度が80%という高いのが興味深いところです。これは単純にコードのバグが減っただけでなく、見た目や操作感の完成度まで向上していることを示唆しています。

一方、複雑な命令を正確にこなすマルチターン対話での進歩も大きな魅力です。Scale社のベンチマーク「MultiChallenge」では、GPT-4.1がGPT-4o比で約10.5%も精度が向上しており、長いやりとりでも指示の意図を取りこぼさずに応答できることがわかります。

「マルチターンで複雑な要素を追加しても混乱することが少なくなったので、より高度なワークフローを支えることができます」とMichelle氏は語っていました。たとえばユーザーが一度決めたフォーマットに従い続ける、あるいは否定的な命令をきちんと尊重するなど、開発者が求めていた細かい操作性が実装されている点が好評のようです。

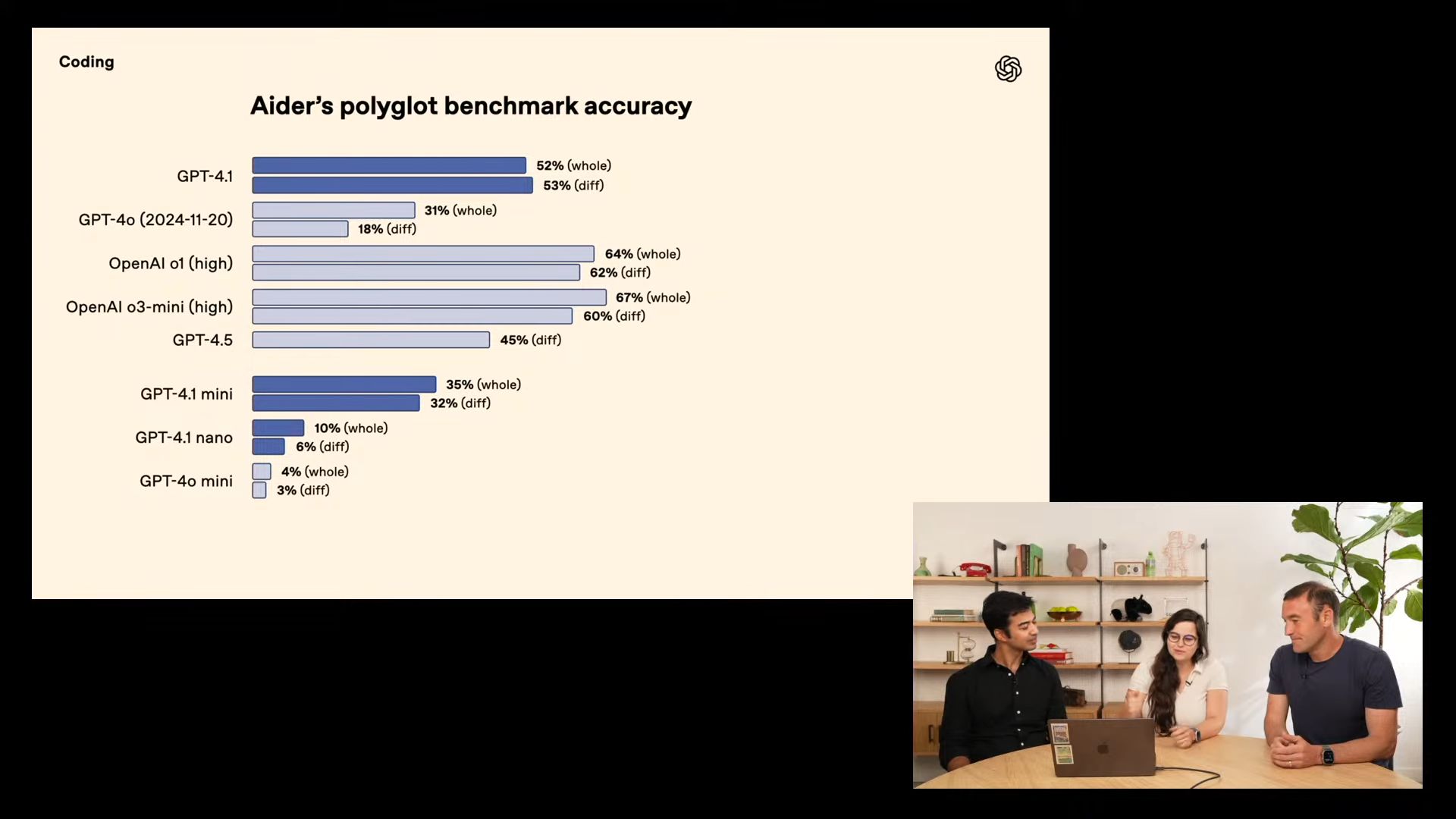

そしてコード生成に関しては、JavaScriptやPythonに限らず、多言語へも適切に展開できる性能も高まっています。「Aider's polyglot diff」の結果では、GPT-4.1がGPT-4oのスコアを大きく上回り、フロントエンドからバックエンド、ツールチェーンまで幅広い場面をカバーしやすいのが印象的でした。

Aider's polyglot benchmarkのスコアです。

超長文コンテキスト処理と"needle in a haystack"テスト

最大のトピックとも言えるのが、GPT-4.1が最大100万トークンまでを扱えるようになった点です。これによって、長大な法務文書や大規模データのレビューがモデル1回の呼び出しで済んでしまう可能性が高まり、従来の分割・結合方式の手間を省けるのは大きなメリットと言えます。ちなみに、出力トークンも従来の16kから32kに増えているので、さらに実用度が高まっています。

「以前の12万8000トークン上限から約8倍もの拡張は、まさに画期的だ」とKevin氏も興奮気味に話していました。

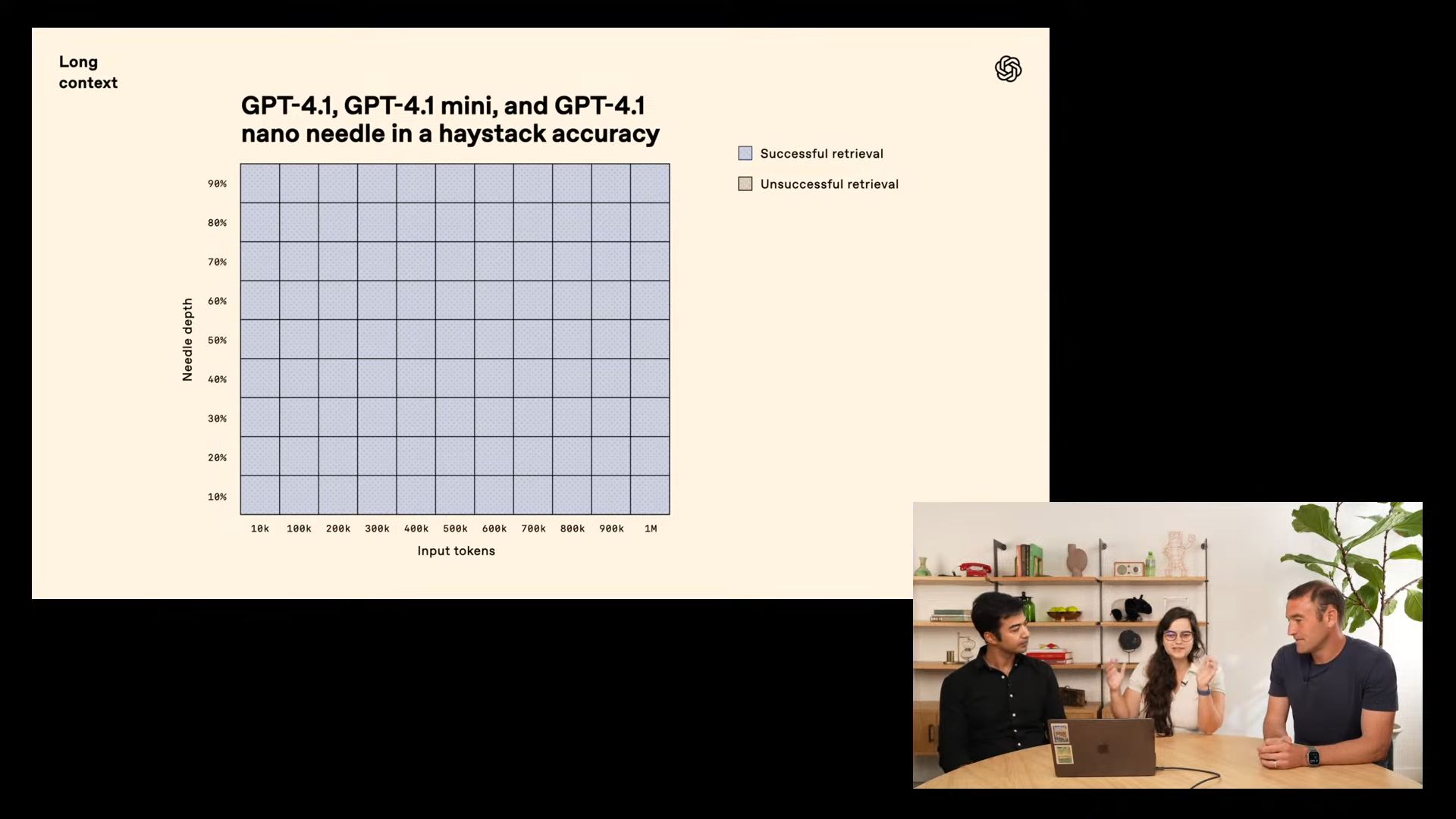

ただし、コンテキスト上限を増やすだけでは意味がなく、その膨大な範囲に散りばめられた情報を正確に拾う力が必要です。そこでOpenAI側が試みているのが「needle in a haystack」というテストです。これは巨大なテキスト群の中に1行だけ違う情報を紛れ込ませ、それをモデルに見つけさせる実験で、GPT-4.1はどの位置に置かれた"針"でも高い精度で発見できたとのこと。

さらに、実際には「必要な複数の文章を関連付ける複雑なクエリ」への対応を測るための「OpenAI-MRCR(マルチラウンド コアリファレンス)」や「Graphwalks」といった評価指標でも好成績を残しています。複雑な指示が交錯しても、どの箇所に何が書かれているかをトレースしながら必要な答えを引き出す力が格段に強化されたというわけです。

GPT-4.1、GPT-4.1 mini、GPT-4.1 nanoのすべてがコンテキスト内のすべての位置で針を取得できました。

GPT-4.1を実際に使ってみた

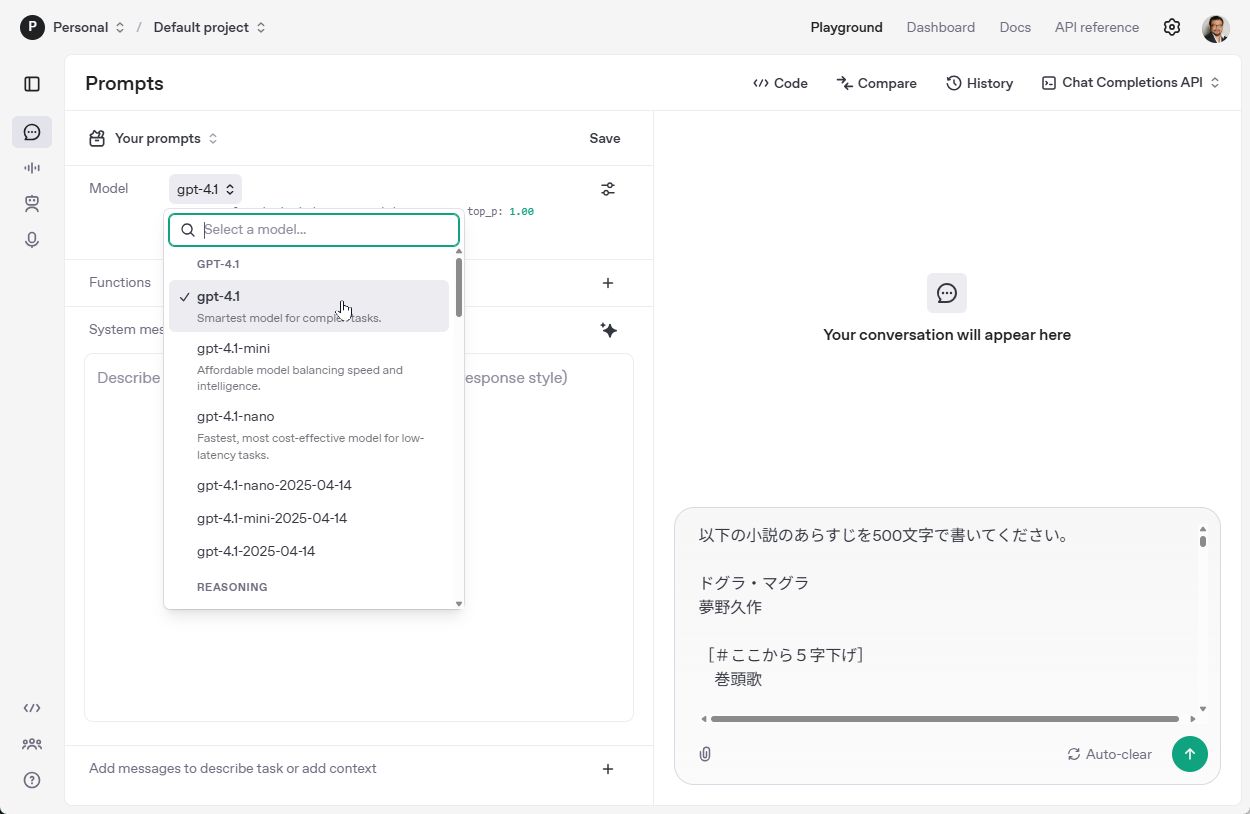

GPT-4.1はAPI経由で提供されているので、自分のAPIを利用する「Playground」で試してみました。モデルの選択メニューに、GPT-4.1とGPT-4.1 mini、GPT-4.1 nanoが追加されています。

早速、GPT-4.1を選び、青空文庫で公開されている夢野久作の長編作品「ドグラ・マグラ」のテキストを読み込ませてみます。文字数は45万4774文字で、ルビなどが含まれて約46万8000文字となっています。OpenAIのTokenizerで計算したところ、39万9429トークンでした。

このテキストを丸ごと入れて、要約してもらったところ、9秒で生成が始まり、20秒も経たずに完了しました。なお、GPT-4oで15秒で生成が始まり、25秒ほどかかりました。

きちんと要約されていました。有名な小説なので、すでに学習済みのデータからあらすじを出力する可能性もあるので、2人の登場人物を別の名前に置換してみました。要約はきちんと置換後の名前が表示されているので、きちんと全文を読んでいることがわかります。

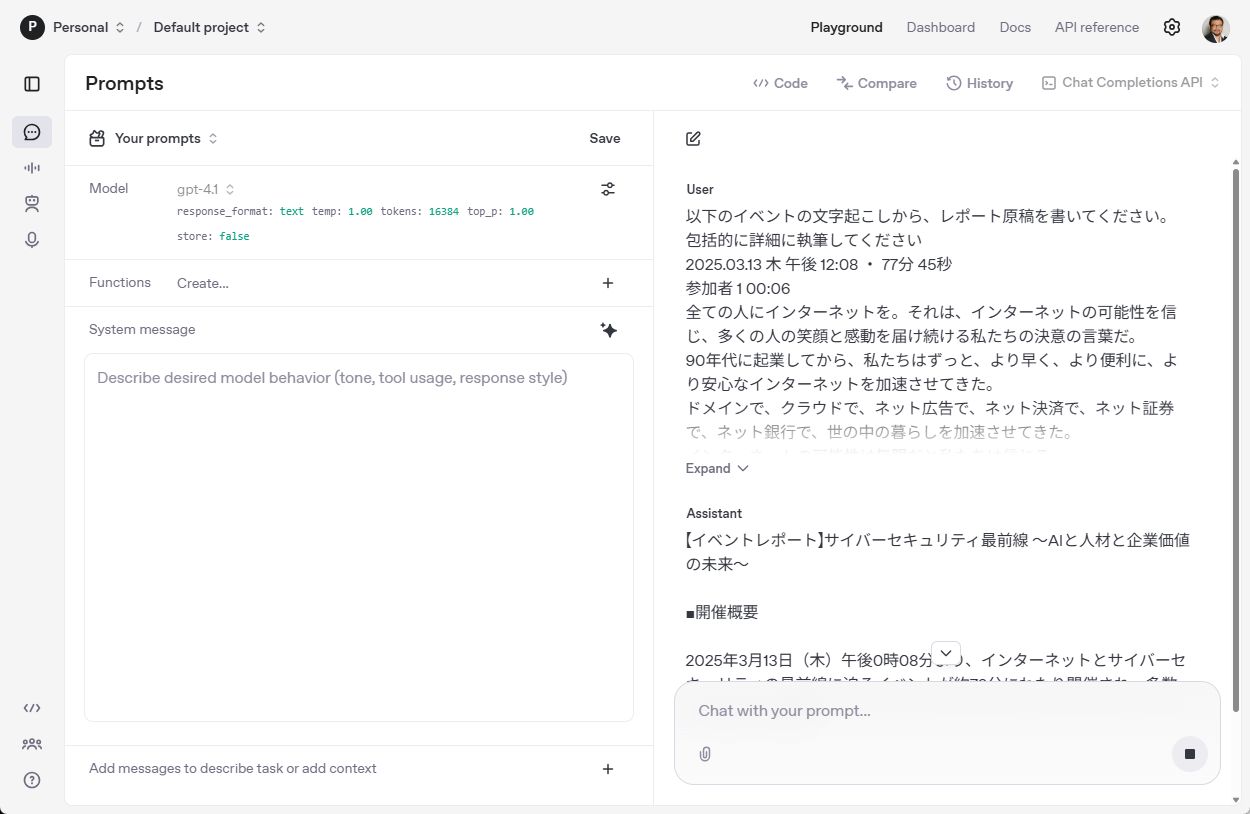

原稿の執筆にもチャレンジしてみましょう。約77分のリアルイベントの録音データから文字起こしをした約3万文字のテキストを入力し、レポート原稿を書くように指示しました。こちらも、あっと言う間に出力が始まり、出力スピードも速いです。きちんと最初から最後まで読んで、出力してくれました。

とにかく、GPT-4.1は高速です。GPT-4.1 nanoだと1秒も待たずに出力がスタートします。GPT-4.1でも一呼吸すれば描き始めます。もう3万文字くらい余裕で扱えるのでしょう。出力のクオリティも上々です。ただし、GPT-4.1とGPT-4oの差はわかりませんでした。

マルチモーダル解析で動画・画像も強化

GPT-4.1はテキストベースだけでなく、マルチモーダル解析の性能も向上しています。GPT-4.1 miniでさえ、画像認識においてGPT-4oを上回る性能を示し、数学的要素が含まれる図表やチャート、地図データなどを的確に読み解くことができます。

「Video-MMEベンチマーク」でも72.0%というスコアを出しており、長時間のビデオの内容を字幕なしで把握するような場面でも活躍が期待できそうです。エンターテインメント関連の動画だけでなく、学術講義やカンファレンス映像の要約など、多岐にわたる分野で実用性を発揮しそうですね。

Ishaan氏は「画像認識と長文コンテキストの両面が掛け合わされることで、ビデオ解析が一気に実用的になりました」とコメントしていました。これらの技術は今後、企業のカスタマーサポートやセキュリティ分野、クリエイティブ産業などでも広がりを見せるのではないでしょうか。

なお、GPT-4.1 nanoも1万行を超えるようなテキストと画像データを組み合わせた場合において、短時間で結果を返す能力を持つとされ、用途に応じてモデルを切り替える戦略が有効になりそうです。大がかりな映像処理を要するならmini以上、ライトな画像分類ならnanoといった具合に調整できるため、使い分けがますます重要となるでしょう。

料金体系と将来展望、そしてGPT-4.5 Previewの廃止

GPT-4.1シリーズは、性能向上だけでなくコスト面も大きく改善されています。標準モデルのGPT-4.1がGPT-4o比で26%安価になり、出力1Mトークン当たり0.50ドルという低価格が魅力的です。さらにGPT-4.1 miniは出力1Mトークン当たり0.10ドル、GPT-4.1 nanoにいたっては0.025ドルとリーズナブルで、キャッシュ割引も最大75%(従来は50%)まで拡大しています。Kevin氏が「開発者が利用すればするほど、実用的メリットとコスト削減を両立できるはずです」と自信を見せていたのも納得です。

注目は、従来のGPT-4.5 Previewが2025年7月14日でAPI提供終了になる点です。GPT-4.1の圧倒的性能とコストメリットを踏まえて、OpenAIとしてはリソースを4.1系へ集中させたいという意図がうかがえます。元々GPT-4.5は研究プレビューという位置づけで、その開発で得られた成果やノウハウは4.1に統合していくとのことです。

では、GPT-4.1をどう取り入れるかという具体策ですが、Agent型AIとしての活用が挙げられます。ユーザーの代わりにタスクを自動で遂行するシステムを構築し、GPT-4.1の強力な理解力と指示遵守力を生かすことで、問い合わせ対応や意思決定を大幅に効率化する試みが進むでしょう。

実際、WindsurfやQodoといった開発ツールでも導入が始まっており、「実際にPull Requestのレビューを自動化させたら、人的コストが激減した」という成功談が次々と報告されています。このトレンドは今後いっそう加速していきそうです。

GPT-4.1シリーズの料金プランです。

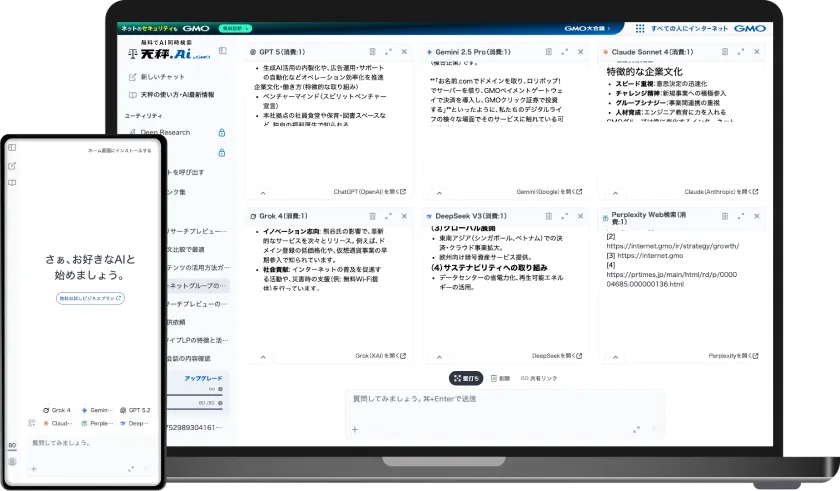

今すぐ最大6つのAIを比較検証して、最適なモデルを見つけよう!

この記事の監修

柳谷智宣(Yanagiya Tomonori)監修

ITライターとして1998年から活動し、2022年からはAI領域に注力。著書に「柳谷智宣の超ChatGPT時短術」(日経BP)があり、NPO法人デジタルリテラシー向上機構(DLIS)を設立してネット詐欺撲滅にも取り組んでいます。第4次AIブームは日本の経済復活の一助になると考え、生成AI技術の活用法を中心に、初級者向けの情報発信を行っています。