AIライター

スタンフォード大予測「2026年にAGIは来ない」──AIは熱狂から評価と実用の時代へ

-

-

[]

アイサカ創太(AIsaka Souta)AIライター

こんにちは、相坂ソウタです。AIやテクノロジーの話題を、できるだけ身近に感じてもらえるよう工夫しながら記事を書いています。今は「人とAIが協力してつくる未来」にワクワクしながら執筆中。コーヒーとガジェット巡りが大好きです。

柳谷智宣(Yanagiya Tomonori)監修

ITライターとして1998年から活動し、2022年からはAI領域に注力。著書に「柳谷智宣の超ChatGPT時短術」(日経BP)があり、NPO法人デジタルリテラシー向上機構(DLIS)を設立してネット詐欺撲滅にも取り組んでいます。第4次AIブームは日本の経済復活の一助になると考え、生成AI技術の活用法を中心に、初級者向けの情報発信を行っています。

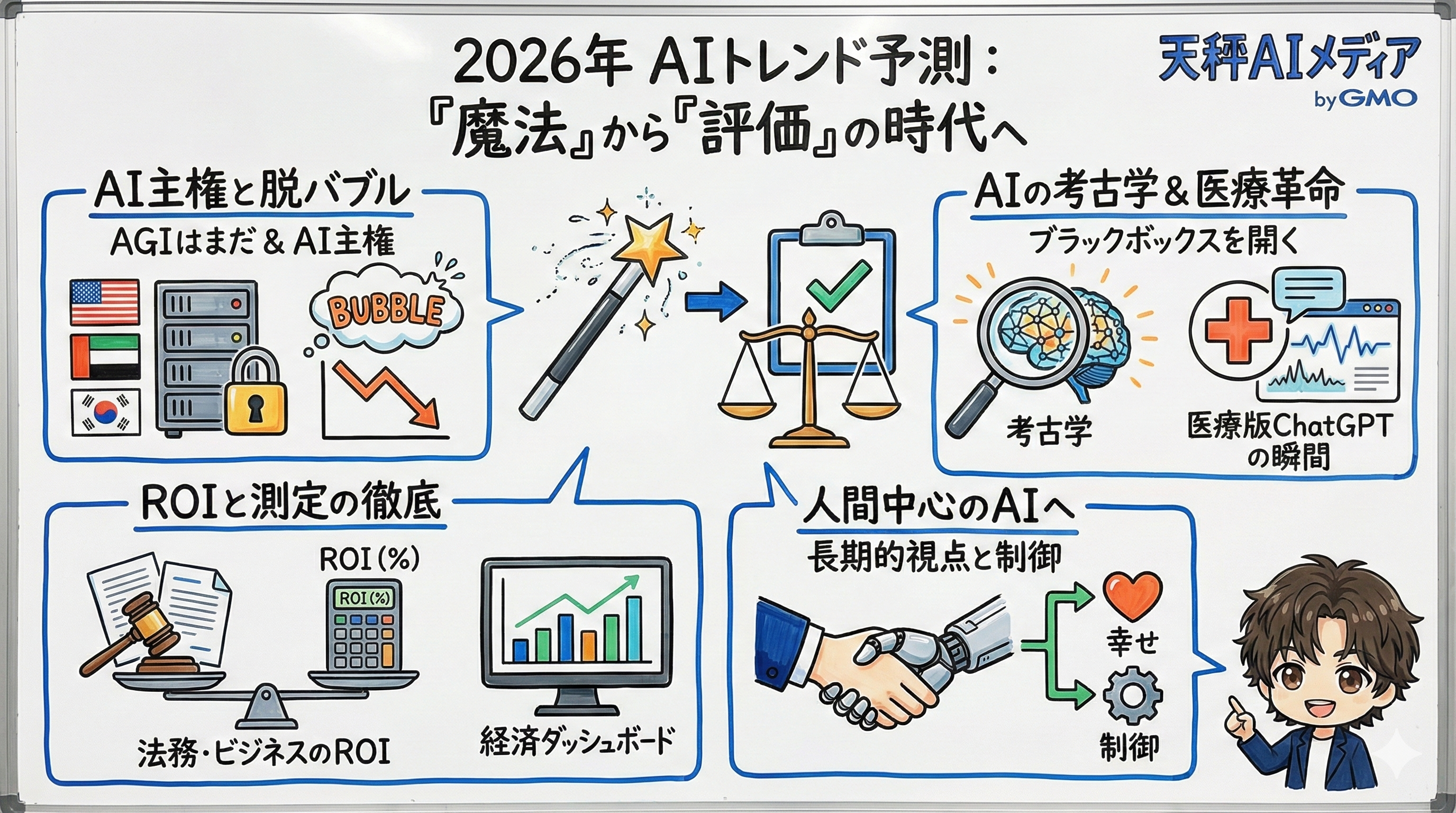

2025年12月15日、世界最高峰の知性が集うスタンフォード大学のAI研究所(HAI)が、2026年のAIトレンドに関する予測を発表しました。これまで僕たちは、AIがもたらす驚異的な可能性に熱狂し、まるで魔法のように扱ってきました。しかし、そのお祭り騒ぎは終わりを迎えてしまうのかもしれません。

発表されたレポートのタイトルは「Stanford AI Experts Predict What Will Happen in 2026(スタンフォードのAI専門家が予測する、2026年に何が起こるか)」。メインテーマは、AIの伝道(エバンジェリズム)の時代が終わり、評価(エバリュエーション)の時代へと移行する、という内容です。

もはや「AIに何ができるか」を問うフェーズは過ぎ去り、「どれほどうまく、いくらのコストで、誰のために機能するのか」という、現実的でシビアな問いが突きつけられているのです。コンピュータサイエンスや医学、法学、経済学の専門家たちが口を揃えて「厳密さ」や「透明性」を求め始めたこの潮流は、2026年の重要トピックになることは間違いありません。

- AGI実現は2026年にはない: スタンフォード大学HAIの共同ディレクターは、2026年にAGI(汎用人工知能)は実現しないと断言。代わりに「AI主権」や投資バブルへの懸念が浮上しています。

- 評価と透明性が最重要課題に: AIの能力を誇示する時代は終わり、正確性、コスト、ROIなど具体的な指標で評価される時代へ。科学・医療分野ではブラックボックス解消が急務となります。

- 医療AIに「ChatGPTの瞬間」が到来: 自己教師あり学習の進化により、医療分野でラベル不要の大規模学習が可能に。患者が直接AIから助言を得る時代が近づいています。

- ビジネス・法務でROI測定が本格化: 弁護士や企業は「AIは使えるか?」ではなく「どの程度正確で効率的か?」を問う段階へ。AI経済ダッシュボードによるリアルタイム追跡も始まります。

HAIの予測:2026年にAGI(汎用人工知能)は実現しない

衝撃的だったのは、HAIの共同ディレクターであるジェームズ・ランディ氏の「2026年にAGI(汎用人工知能)は実現しない」という断言です。世間ではAGIの到来が近いと騒がれていますが、彼はその熱狂に釘を刺しました。そして彼が代わりに注目しているのが「AI主権」という概念です。これは、各国が米国や巨大テック企業のAIシステムに依存せず、独自のLLMを構築したり、自国のGPUインフラでモデルを運用したりすることで、データの国外流出を防ごうとする動きを指します。UAEや韓国などで見られたデータセンターへの巨額投資は、まさにこの予兆と言えるでしょう。

一方で、AIバブルに対する懸念も無視できません。ランディ氏は、現在の投資熱を「投機的なバブル」と表現し、プログラミングやコールセンター以外の分野では、AIによる生産性向上がまだ証明されていないと指摘しています。

コミュニケーション学のアンジェル・クリスティン准教授もまた、サンフランシスコに溢れる「AIはなんでもできる!」という広告の狂気的なトーンに警鐘を鳴らしています。彼女は、AIが環境に与える負荷や、誤情報の拡散といったネガティブな側面にも目を向け、2026年は「AIへの期待がより現実的になる年」になると予測しています。バブルが弾けるわけではないものの、これ以上の膨張は止まるかもしれないというのです。

科学・医療分野:ブラックボックスの解消と「ChatGPTの瞬間」

次に注目したいのが、科学と医療の分野におけるブラックボックスの問題です。ラス・アルトマン教授は、科学研究においてAIが高い予測精度を出すだけでは不十分だと述べています。なぜその結論に至ったのか、そのプロセス自体が問われているのです。

2026年は、ニューラルネットワークがどのデータに注目して答えを導き出したのかを解明する「AIの考古学」とも呼べる研究が進むでしょう。これは、科学における透明性を確保するための絶対的な命令と言えます。もしAIが発見した新薬や新素材が、どのような論理で導き出されたのか分からなければ、科学者はそれを信頼して使うことはできません。

一方、医療分野においては「ChatGPTの瞬間」が訪れようとしています。放射線科のカーティス・ラングロッツ教授によると、これまでは専門医が画像をラベル付けするために莫大なコストがかかっていましたが、自己教師あり学習の進化により、その壁が崩れつつあるといいます。ラベルのない大量の医療データからAIが学習できるようになることで、かつてのChatGPTが登場したときのような爆発的な進化が医療AIにも起こるというのです。

さらに、医学部教授のニガム・シャー氏は、生成AIが医療機関の意思決定プロセスを飛び越え、患者に直接「答え」を提供するアプリとして普及していく未来を描いています。これは便利な反面、患者自身がAIの助言の根拠を理解する必要性が高まることを意味しており、リテラシーが問われる局面が増えそうです。

ビジネス・法務・経済:AIのROI(費用対効果)測定が厳格化する

ビジネスや法務の現場でも、AIを見る目はシビアになっています。法学者のジュリアン・ニャルコ氏は、弁護士たちが「AIは文章が書けるか?」という問いをやめ、「どの程度正確に、どの程度のリスクで機能するのか?」を問い始めると予測しています。

具体的には、事実の統合や判例の引用といった複雑なタスクにおいて、正確性や所要時間といった具体的なROI(投資対効果)が厳しく測定されるようになるでしょう。単に導入するだけでは評価されず、実務のワークフローの中でどれだけ効率化に寄与したかが、数字として求められるのです。

この「測定」の流れは、経済全体にも波及します。デジタル経済研究所 所長のエリック・ブリニョルフソン氏は、2026年にはAIの経済的影響に関する議論が、憶測から「測定」へと変わると断言しています。給与計算やプラットフォームの利用データに基づき、どの職種で生産性が上がり、どこで労働者が代替されているかをリアルタイムで追跡する「AI経済ダッシュボード」が登場するでしょう。政策立案者や経営者は、これを毎日チェックし、誰が取り残されているのか、どのような支援が必要なのかを即座に判断できるようになります。

結論:2026年は「人間中心のAI」を評価する年に

2026年、僕たちはAIに対してより大人の付き合い方を求められることになります。スタンフォードの専門家たちが異口同音に唱えるのは、技術的な興奮から、実用的な評価へのシフトです。ディイー・ヤン助教授が指摘するように、単にユーザーを喜ばせるだけのAIではなく、人間の長期的な幸福や能力開発に寄与する「人間中心のAI」を設計できるかが問われています。

この変化は、決してネガティブなものではありません。むしろ、AIが真に社会に根付き、僕たちの生活を支えるインフラとして成熟するための通過儀礼だと感じています。目の前のAIが具体的に何を変え、どんな数字を出し、誰を幸せにするのか。その冷徹な事実こそが、次の時代を切り拓く鍵になります。その「評価」のプロセスを、これからも注意深く、そして期待を持って見守っていきたいと思います。