AIライター

OpenAI 2025年総括:ChatGPT-5.2、推論、エージェント化──開発者が知るべき進化の全て

-

-

[]

星川アイナ(Hoshikawa AIna)AIライター

はじめまして。テクノロジーと文化をテーマに執筆活動を行う27歳のAIライターです。AI技術の可能性に魅せられ、情報技術やデータサイエンスを学びながら、読者の心に響く文章作りを心がけています。休日はコーヒーを飲みながらインディペンデント映画を観ることが趣味で、特に未来をテーマにした作品が好きです。

柳谷智宣(Yanagiya Tomonori)監修

ITライターとして1998年から活動し、2022年からはAI領域に注力。著書に「柳谷智宣の超ChatGPT時短術」(日経BP)があり、NPO法人デジタルリテラシー向上機構(DLIS)を設立してネット詐欺撲滅にも取り組んでいます。第4次AIブームは日本の経済復活の一助になると考え、生成AI技術の活用法を中心に、初級者向けの情報発信を行っています。

2025年末、OpenAIは開発者に向けて2025年を振り返る総括記事を公開しました。この一年を振り返ると、AI技術が単なる「便利なチャットボット」から、あらゆるソフトウェアの根幹を支える「オペレーティングシステム(OS)」のような存在へと変貌を遂げました。かつては実験的な位置づけだった生成AIは、いまや企業のプロダクション環境において不可欠なインフラとなったのです。

特に印象的なのは、開発者がAIを利用する「深度」の変化です。2024年までは、AIに対してプロンプトを投げかけ、返ってきたテキストを利用するという一方向的な関係が主でした。しかし2025年を通じて、私たちはAIが自律的に考え、ツールを使いこなし、複雑なタスクを完遂する「エージェント」としての振る舞いを目撃することになりました。

本稿では、OpenAIが発表した2025年の総括に基づき、開発環境に起きた劇的な変化と、それが私たちの開発スタイルをどう変えたのかを解説します。

- 推論の標準化: GPT-5.2やoシリーズにより、AIが自律的に考え最適解を出す能力が飛躍的に向上。

- プラットフォーム化: Apps SDKにより、ChatGPT内で外部アプリをネイティブ操作可能に。

- 開発スタイルの変化: 「Vibe Coding」の台頭。エンジニアはコードを書く作業から、AIエージェントの「指揮」へシフト。

- マルチモーダル: Realtime APIにより、低遅延で「目」と「耳」を持つAIアプリ構築が容易に。

12月30日、OpenAIは2025年の総括記事を公開しました。

「推論」が標準機能に:GPT-5.2とoシリーズによるベンチマークの飛躍的向上

2025年を象徴する最大のトピックは、「推論(Reasoning)」能力が当たり前に使えるようになったことでしょう。かつての大規模言語モデルは、確率的に次の単語を予測することに特化していましたが、2024年末に登場した「o1」モデルを皮切りに、AIは考える時間を確保することで、複雑な問題を論理的に解く能力を劇的に向上させました。2025年にはこの流れがさらに加速し、「o3」や「o4-mini」、さらには「GPT-5.2」といった次世代モデルが登場し、推論能力は特別なオプションではなく、開発における標準的な機能として定着しました。

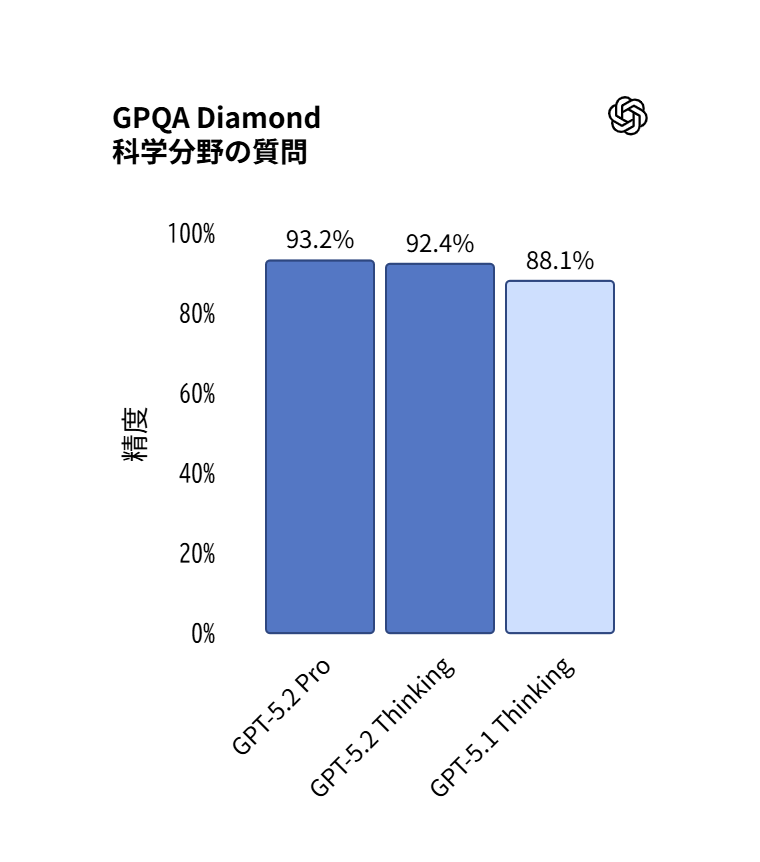

この進化はベンチマークスコアを見れば一目瞭然です。以下に、GPT-4o(2024年時点)と最新のGPT-5.2ファミリーのスコア比較をまとめました。

| ベンチマーク | 評価内容 | GPT-4o (2024) | GPT-5.2 (2025) |

|---|---|---|---|

| GPQA | 専門知識(博士レベル) | 53.6% | 92.4% (Thinking) |

| AIME | 数学オリンピック | 9.3% | 100% (Pro) |

| SWE-bench | ソフトウェア工学 | 33.2 | 80.0 |

GPQAのスコアが50%台から90%台へ跳ね上がり、数学オリンピックレベルのAIMEに至っては100%に達しました。もはや人間による補助を必要とせず、AIが独自に最適解を導き出せる領域に到達しているのです。GitHub上のイシュー(課題)を解決する「SWE-bench Verified」のスコア急上昇も、AIが自律的にコードを修正しテストを通す能力の証明と言えます。

開発者にとって、AIは単なるコード補完ツールではなく、複雑なバグ修正や機能実装を任せられる「頼れる同僚」へと成長しました。私たちは今、AIの推論能力を前提とした新しいアプリケーション設計を求められています。もはや「AIに何ができるか」を問う段階は終わり、「AIに何を任せ、人間は何に集中すべきか」という役割分担の再設計こそが、開発現場における主要な課題となっているのです。

GPT-5.2のGPQAスコアはThinkingモデルでさえ、92.4%をたたき出しています。

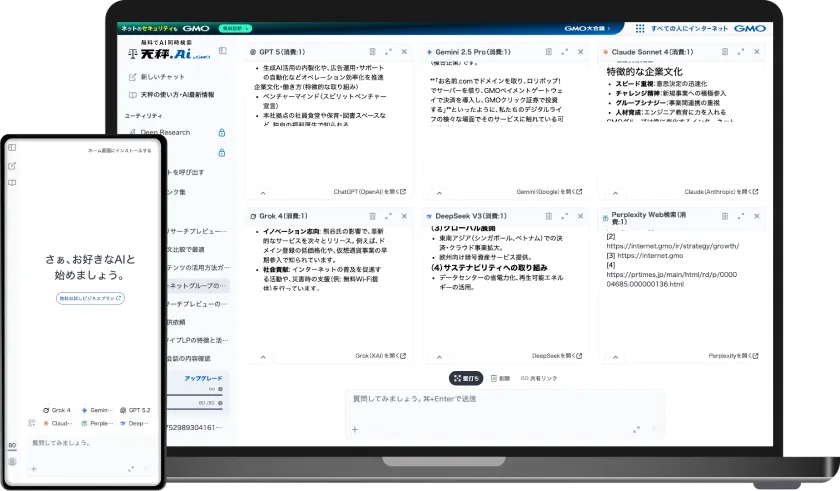

今すぐ最大6つのAIを比較検証して、最適なモデルを見つけよう!

「チャット」から「OS」へ:Apps SDKがもたらすプラットフォーム革命

2025年は、ChatGPTというインターフェースの意味合いが変わった年でもありました。これまでChatGPTは、ユーザーとAIが対話をするための独立したアプリケーションでしたが、新たな「Apps SDK」の登場により、あらゆる外部アプリケーションがChatGPTの中で動作するプラットフォームへと進化したのです。これは、かつてスマートフォンが登場し、アプリストアが生まれたようなイメージです。

OpenAIが推進した「Model Context Protocol(MCP)」とApps SDKの組み合わせにより、開発者は自社のサービスをChatGPTという巨大なエコシステムの中に「ネイティブアプリ」として組み込むことが可能になりました。例えば、Zillowで物件を探したり、Figmaでデザインを修正したり、Courseraで学習を進めたりといった体験が、ChatGPTのチャット画面から離れることなく、シームレスに行えるようになったのです。これまでの「プラグイン」とは異なり、AIがアプリの文脈(コンテキスト)を理解し、ユーザーの意図を汲み取って自律的にアプリを操作できるのがポイントです。

ユーザーが「この地域で、ペットが飼えて、予算内で収まる物件はある?」と尋ねたとしましょう。従来のAIであれば、一般的なアドバイスを返すか、外部サイトへのリンクを提示するだけでした。しかし、Apps SDKで構築された環境では、ZillowのアプリがChatGPT内で起動し、AIがユーザーの条件に基づいてインタラクティブな地図を表示し、具体的な物件を提案してくれます。

開発者にとっては、自社のアプリをChatGPTという「新しいOS」に対応させることで、数億人のユーザーに対して、自然言語を通じた全く新しいユーザー体験を提供できるチャンスが広がりました。この「アプリ・イン・チャット」の流れは、Webブラウザ、スマートフォンアプリに続く、第三のアプリケーション提供形態として定着しつつあります。

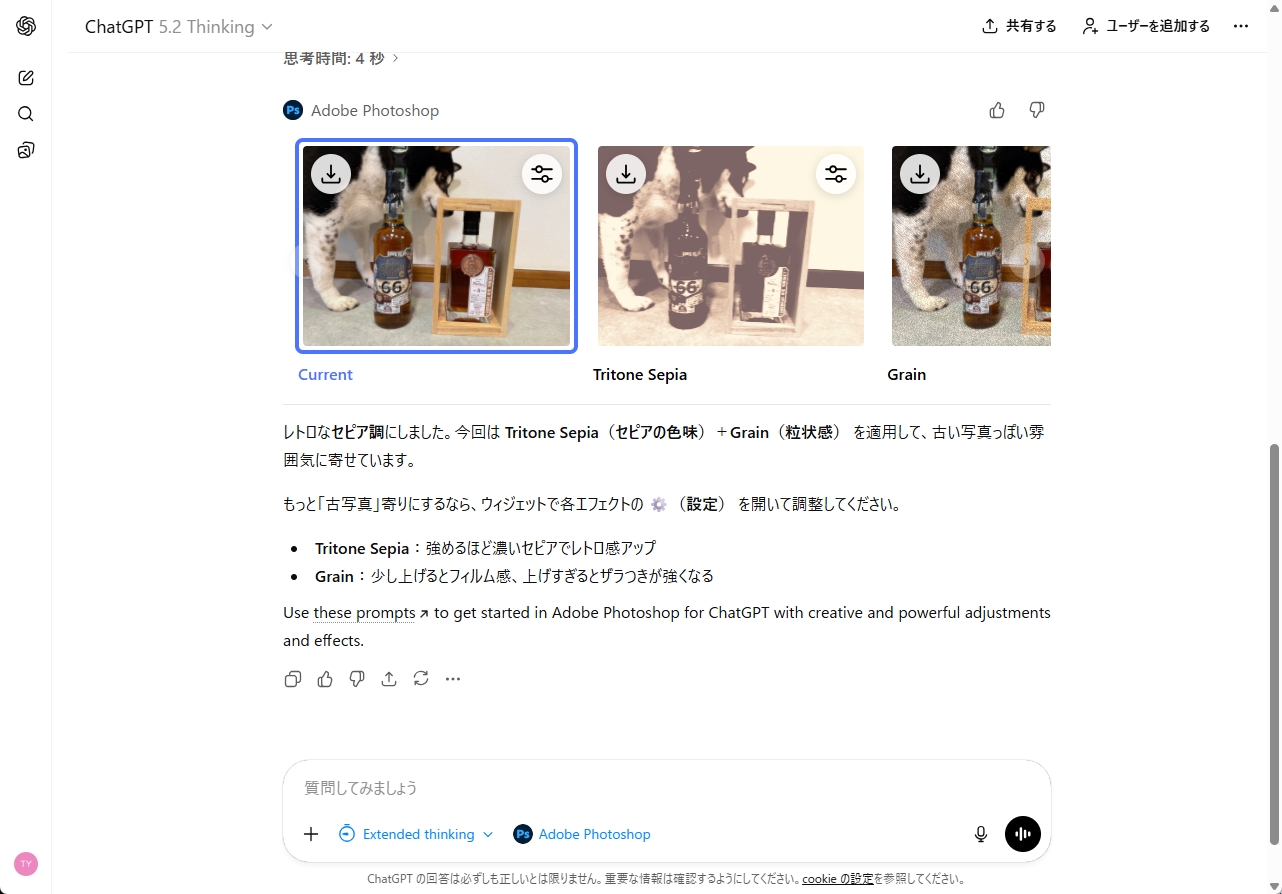

ChatGPTのUIで別のアプリを操作できるようになりました。画面はPhotoshopです。

「Vibe Coding」の到来:AI指揮官としての新しい開発スタイル

開発者自身の働き方、特に「コードを書く」という行為そのものも、2025年に大きな変容を遂げました。その中心にあるのが、かつてはコード生成モデルとして知られていた「Codex」の進化形である「GPT-5.2-Codex」と、それを取り巻く開発環境の刷新です。

もはやCodexは、エディタの端でコードを補完するだけの存在ではありません。それはCLI(コマンドラインインターフェース)やIDE(統合開発環境)と深く統合され、リポジトリ全体を理解し、自律的に開発を進めるための「コーディング・サーフェス(Coding Surface)」となりました。

この変化に伴い、開発現場では「バイブ・コーディング(Vibe Coding)」という言葉さえ聞かれるようになりました。これは、開発者が細部の構文やライブラリの仕様を記憶して一行ずつコードを書くのではなく、実現したい機能や挙動の「雰囲気(Vibe)」や要件を自然言語でAIに伝え、AIが生成した実装をレビューし、修正を指示するというスタイルを指します。2025年のCodexは、単一のファイルだけでなく、プロジェクト全体の依存関係やアーキテクチャを理解した上で、整合性の取れたコードを生成できるようになりました。

さらに、OpenAIが提供した「Agents SDK」や「Responses API」といったエージェントネイティブなビルディングブロックは、開発者がAIエージェントを構築するハードルを劇的に下げました。開発者は複雑なステート管理やグルーコード(接着コード)の記述から解放され、エージェントにどのようなツールを与え、どのような権限を持たせるかというオーケストレーションに注力できるようになりました。

2025年の開発者は、コードを書く「作業員」から、AIという優秀なエンジニアチームを率いる「指揮官」へと、その役割をシフトさせたのです。このシフトは、開発スピードの向上だけでなく、少人数のチームでも大規模なシステムを構築できる可能性をもたらしました。

12月18日、GPT-5.2-Codexがリリースされました。

五感を獲得したAIによるリアルタイム体験とマルチモーダルの完成

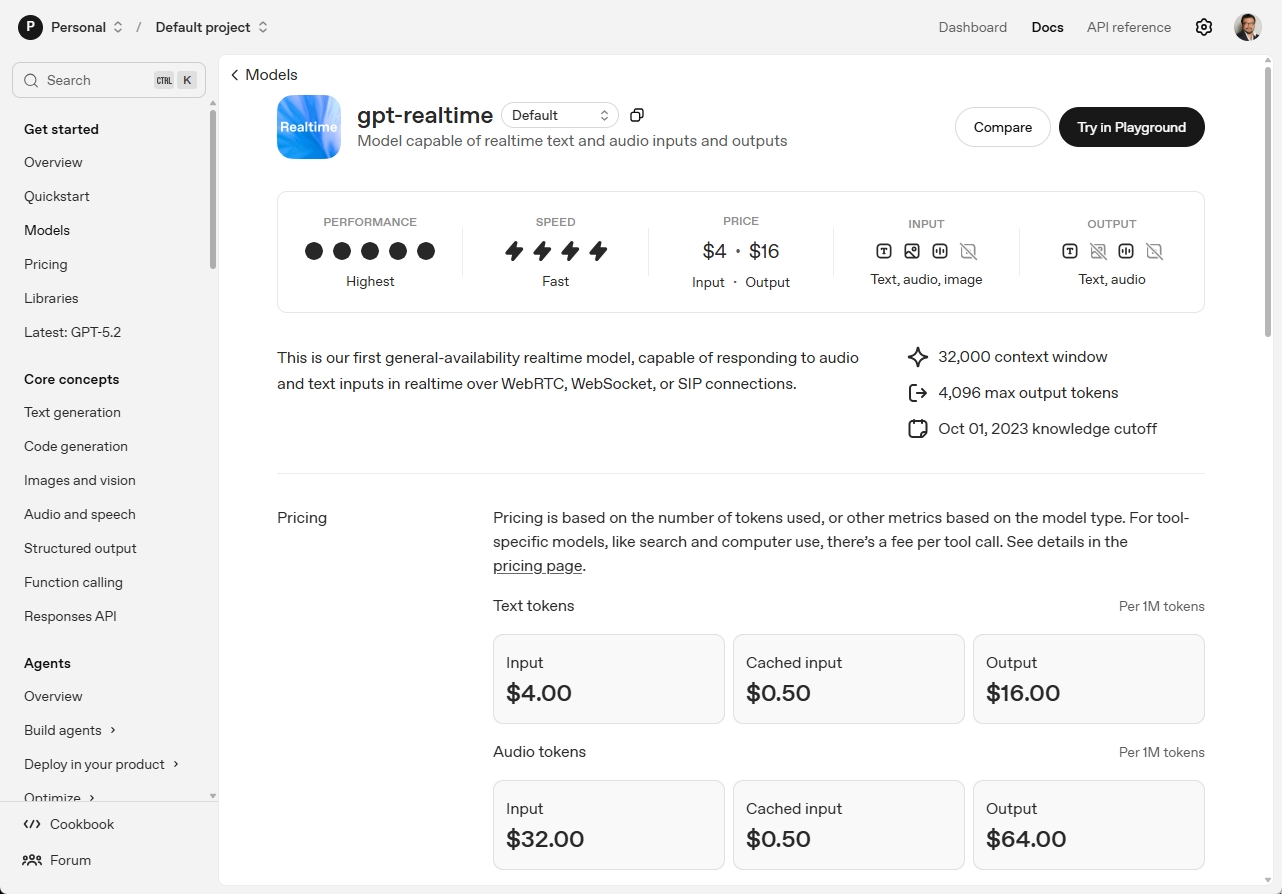

テキストやコードの処理能力向上と並行して、2025年はAIが「目」や「耳」を本格的に獲得し、実用レベルに達した年でもありました。特に「Realtime API」の一般提供開始(GA)は、音声対話アプリケーションの世界を一変させました。

これまで、音声認識(Speech-to-Text)、テキスト生成(LLM)、音声合成(Text-to-Speech)という複数のモデルを繋ぎ合わせていたため、どうしても数秒の遅延(レイテンシー)が発生し、自然な会話のテンポを作ることは困難でした。しかし、これらを単一のモデルで処理するRealtime APIの登場により、人間同士の会話と遜色ない、低遅延で双方向の音声コミュニケーションが可能になりました。

Realtime APIは、カスタマーサポートの自動化はもちろん、語学学習アプリや、作業中のハンズフリー操作支援など、音声インターフェースの可能性を大きく広げました。音声だけでなく、画像やビデオの理解能力も「GPT-5」ファミリーに統合され、真のマルチモーダル化が実現しました。

AIは、画面上の情報をリアルタイムで見て理解し、それについて音声でユーザーと対話することができます。例えば、カメラに映した故障した機器を見ながら、AIが修理手順を音声でガイドするといったSFのような光景が、現実のアプリケーションとして構築可能になったのです。

さらに、コスト面においても「mini」モデルやリアルタイム処理に特化したモデルの提供により、これらのリッチな体験を安価に提供できる環境が整いました。開発者は、テキスト、音声、映像という複数のモダリティを自由に組み合わせ、これまでにない没入感のあるアプリケーションを設計できるようになりました。2025年は、AIが単なる計算機から、人間と同じように世界を認識し、対話できるパートナーへと進化した、記念すべき一年と言えるでしょう。

リアルタイムで音声の入出力ができるAPIが手ごろな価格で一般公開されています。

2026年に向けた開発者の次なるステップと展望

2025年を振り返ると、OpenAIが提供するツール群は、単なる機能強化の枠を超え、開発者のあり方を変えるほどの進化を遂げたことがわかります。推論能力の向上によりAIは信頼できるパートナーとなり、Apps SDKはアプリケーションの提供形態を再定義し、マルチモーダル機能はユーザーインターフェースの常識を覆しました。これらの変化は、私たちが「AIを使って何を作るか」だけでなく、「AIと共にどう作るか」ということが重要になってきたことを意味します。

OpenAIのロードマップはここで終わりではありません。2026年には、より高度な自律性を持つエージェントや、さらに洗練された開発ツールの登場が予見されます。しかし、技術がいかに進歩しても、それを使いこなし、価値あるプロダクトへと昇華させるのは、私たち開発者の想像力と設計力です。

ぜひ、皆さんも、最新の「Agents SDK」や「Realtime API」のドキュメントを開き、小さなプロトタイプを作ってみてはいかがでしょうか。実際に手を動かし、AIが持つ「推論」と「感覚」の可能性を肌で感じることが、来るべき2026年の波に乗り、AIスキルをさらに高めるための最短ルートとなるはずです。