AIライター

AIと人間の思考順序が一致!Meta AIが解明した、モデルとコンテキストが思考に与える影響

-

-

[]

アイサカ創太(AIsaka Souta)AIライター

こんにちは、相坂ソウタです。AIやテクノロジーの話題を、できるだけ身近に感じてもらえるよう工夫しながら記事を書いています。今は「人とAIが協力してつくる未来」にワクワクしながら執筆中。コーヒーとガジェット巡りが大好きです。

柳谷智宣(Yanagiya Tomonori)監修

ITライターとして1998年から活動し、2022年からはAI領域に注力。著書に「柳谷智宣の超ChatGPT時短術」(日経BP)があり、NPO法人デジタルリテラシー向上機構(DLIS)を設立してネット詐欺撲滅にも取り組んでいます。第4次AIブームは日本の経済復活の一助になると考え、生成AI技術の活用法を中心に、初級者向けの情報発信を行っています。

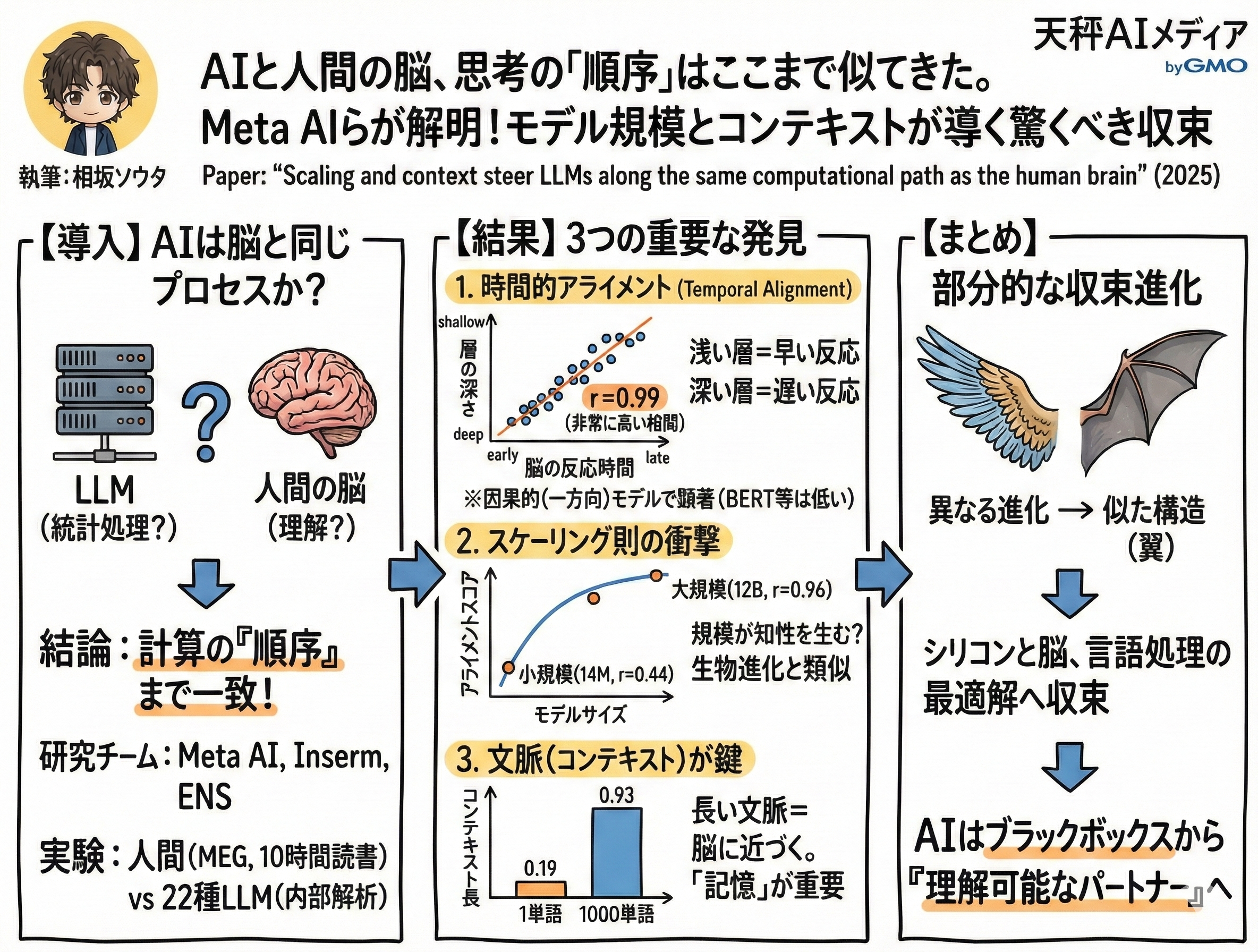

大規模言語モデル(LLM)は、単に膨大なテキストデータを統計的に処理しているだけなのでしょうか、それとも、人間の脳と同じようなプロセスで言葉を理解しているのでしょうか。この問いは、AI研究における最大のミステリーの一つと言えます。

2025年12月、Meta AIとフランスの国立衛生医学研究所(Inserm)、エコール・ノルマル・シュペリウール(ENS)の共同研究チームが発表した論文「Scaling and context steer LLMs along the same computational path as the human brain(スケーリングとコンテキストが、LLMを人間の脳と同じ計算経路へと導く)」は、この謎に一つの答えを提示しました。

彼らが挑んだのは、AIのニューラルネットワークと人間の脳活動が、単に結果として似た表現を持つだけでなく、その「計算の順序」までもが一致しているかという検証でした。これまでもAIと脳の類似性を指摘する研究はありましたが、今回の報告は、その類似性が「なぜ」生まれるのか、その発生条件を大規模な実験データに基づいて定量的に明らかにしました。

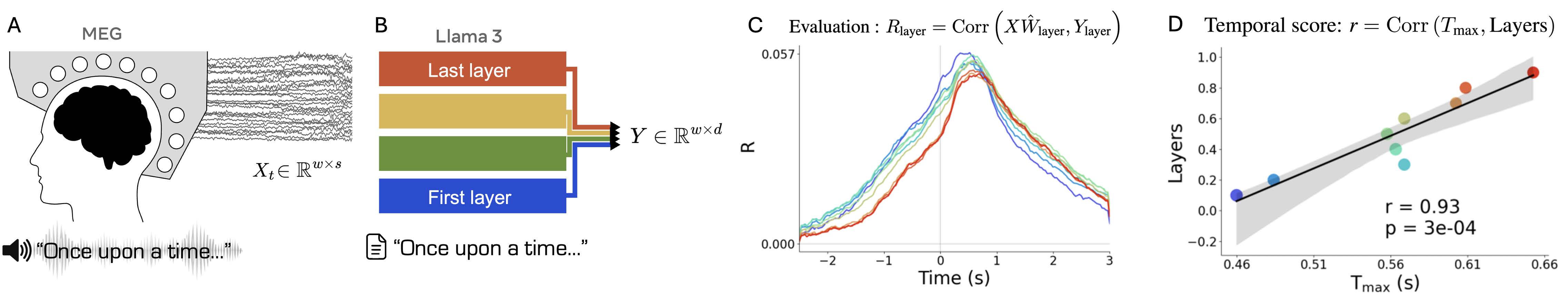

研究チームは、3人の健康な参加者が合計10時間にわたってオーディオブックを聞いている際の脳磁図(MEG)データを解析しました。そして、この人間の脳活動データと、Llama 3やMistral、GPT-2などを含む、アーキテクチャやサイズの異なる22種類ものLLMの内部挙動を徹底的に比較したのです。

読書中の脳波とLLMの各層の反応を比較し、処理順序の一致度を測定する実験の概要図です。画像は論文より。

「浅い層」は早く、「深い層」は遅く。脳とAIが共有する処理のタイムライン

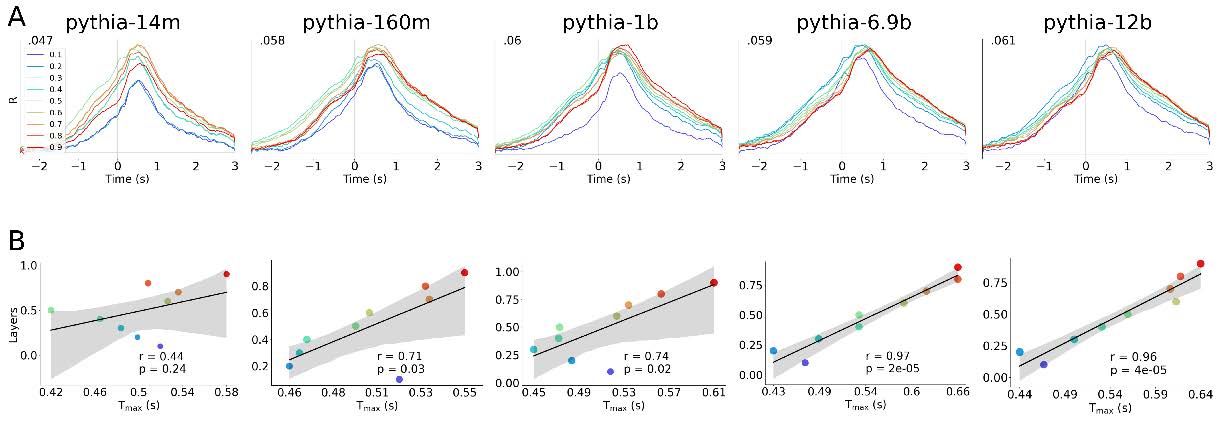

まず、この論文の核心部分である「時間的アライメント」について解説します。研究チームは、LLMの各層(レイヤー)がテキストを処理するタイミングと、人間の脳が単語を聞いてから反応するまでの時間の関係を分析しました。通常、ディープラーニングモデルは入力層から出力層へと情報を順伝播させますが、この情報の流れが、人間の脳内での処理順序とどれほどリンクしているのかを調べたのです。

結果は驚くほど綺麗な相関を示しました。解析によると、LLMの「浅い層(初期の層)」の活性化パターンは、脳が単語を聞いた直後の「早い段階」の反応と最も強く相関していました。逆に、LLMの「深い層(後期の層)」の活性化は、脳の「遅い段階」の反応と一致していたのです。

単語の開始から約0.4秒後あたりでアライメントスコアが上昇し、層が深くなるにつれて、対応する脳活動のピーク時間も遅くなっていく傾向が確認されました。

これは、単にAIが脳と同じような情報を保持しているだけでなく、情報を処理するステップ、つまり「思考の順序」までもが人間に似ていることを意味します。グラフ上の相関係数(r)は0.99という極めて高い数値を叩き出しており、統計的にも偶然とは考えにくい強固な関係性が示されています。まるでAIが人間の脳の処理プロセスをトレースしているかのようなこの現象は、Llama 3のような最新モデルだけでなく、Mambaのような状態空間モデル(SSM)でも確認されました。

一方で、興味深い対照実験も行われています。BERTやRoBERTaといった、文脈を双方向から見る(未来の単語も参照できる)タイプのモデルや、音声認識モデルであるWav2vec 2.0と比較した場合、これらは高い表現アライメントを持ちながらも、この「時間的な順序」に関しては低いスコアしか記録しませんでした。つまり、人間と同じように過去から未来へと一方向に言葉を紡ぐ「因果的」なモデルこそが、脳の計算パスを再現しているのです。

各LLMにおける層の深さと脳反応のピーク時間の相関です。

今すぐ最大6つのAIを比較検証して、最適なモデルを見つけよう!

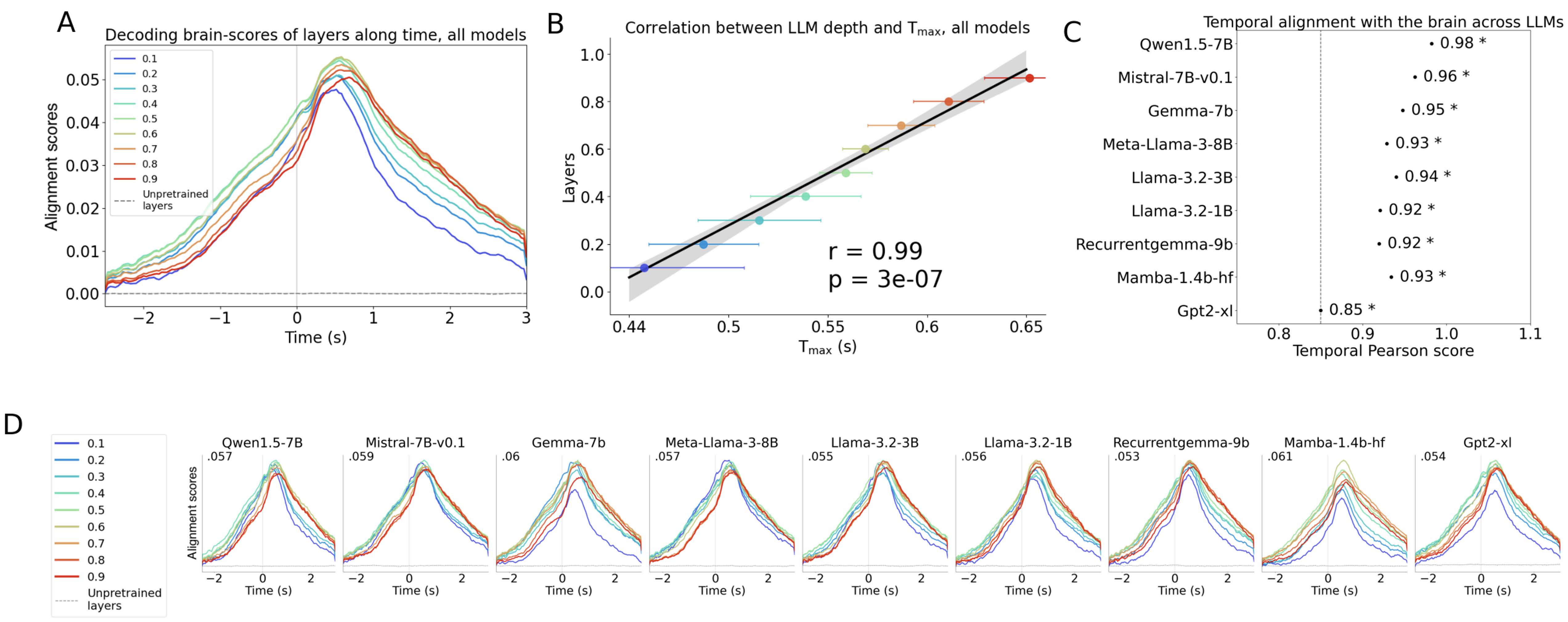

規模が知性を生むのか?「スケーリング則」が脳との同調にも適用される衝撃

次は「モデルのサイズ」が脳との整合性にどう影響するかという研究です。近年、AI開発においては「Scaling Law(スケーリング則)」、つまりモデルを大きくすればするほど性能が向上するという経験則が支配的ですが、これが脳との類似性においても当てはまるのかを研究チームは検証しました。ここで用いられたのが、1400万パラメータから120億パラメータまでサイズのみを変えて統一的に訓練された「Pythia」ファミリーというモデル群です。

実験データは正直でした。現代の基準では小規模な1400万パラメータというモデルにおいては、脳活動との時間的な相関はほとんど見られませんでした(r=0.44、有意差なし)。しかし、モデルのサイズを大きくしていくにつれて、アライメントスコアは対数的に上昇していきました。そして、最大の120億パラメータのモデルにおいては、相関係数は0.96という高い値に達したのです。

AIが人間の脳のような計算プロセスを獲得するためには、ある一定以上の規模が必要不可欠であるということです。小さな脳(モデル)では再現できない処理の深さが、ニューロン(パラメータ)の数を増やすことで自然発生的に現れてくる。これは、生物の進化において脳の容量が増大し、高度な知性が芽生えたプロセスを彷彿とさせます。

AIのスケーリング則が、単なるベンチマークテストのスコア向上だけでなく、生物学的な妥当性の向上にも寄与しているのは、巨大モデル開発の正当性を後押しする強力な根拠となるでしょう。

ただし、この上昇カーブには限界も見え隠れしています。700億パラメータクラスの巨大モデル(Llama 3.3 70B)まで検証範囲を広げても、比較的小さなLlama 3.2 3Bと比べて劇的なスコア向上は見られず、ある程度のサイズで頭打ちになる傾向も確認されました。これは、単に闇雲にサイズを大きくすれば良いというわけではなく、脳との完全な同調に至るには、サイズ以外の要素も重要になってくることを予感させます。

モデルサイズが大きくなるにつれ、脳活動との時間的相関が対数的に向上しているのがわかります。

文脈を読む力こそが鍵。コンテキスト長が脳との距離を縮める

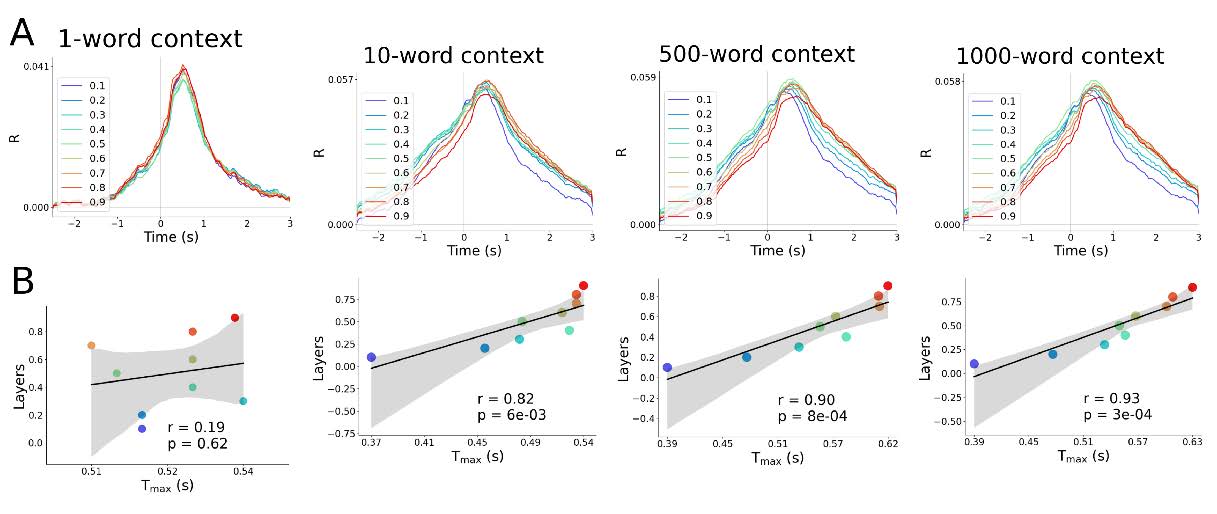

サイズと同じくらい、あるいはそれ以上に重要なのは「コンテキスト長(文脈の長さ)」の影響です。人間が言葉を理解するとき、単にその瞬間の単語だけを見ているわけではありません。それまでの会話の流れや物語の文脈を記憶し、それを踏まえて次の言葉を予測します。研究チームは、Llama 3.2 3Bモデルに入力するテキストの長さを1単語から1000単語まで変化させ、脳とのアライメントがどう変化するかを調査しました。

結果は想像以上のものでした。たった1単語しか与えられなかった場合、モデルの脳との時間的相関スコアは0.19にとどまり、統計的に意味のある一致は見られませんでした。しかし、コンテキストを10単語、500単語と増やしていくにつれ、スコアは急上昇し、1000単語のコンテキストを与えた状態では0.93という極めて高い値を記録しました。つまり、AIが長い文脈を考慮して推論を行うときほど、その計算プロセスは人間の脳に近づくのです。

この発見は、AIにとって記憶や文脈がいかに本質的な要素であるかを浮き彫りにしています。興味深いことに、トランスフォーマーのようなアテンション機構を持つモデルだけでなく、Mambaのような状態空間モデルでも同様の傾向が見られました。状態空間モデルは、過去の情報を圧縮された「隠れ状態」として保持する仕組みですが、それでも長い文脈を与えることで脳とのアライメントが向上しました。これは、脳が有限のリソースの中で文脈を保持・処理しているメカニズムと、AIの処理形式が、アーキテクチャの違いを超えて収束している可能性を示しています。

さらに研究チームは、「次の単語の予測しやすさ」がこの結果に影響しているのではないかという疑念に対しても、慎重な検証を行っています。予測しやすい単語と、予測が難しい(意外な)単語にデータを分けて分析しましたが、どちらのグループでも高い時間的アライメントが維持されていました。つまり、AIが脳に似ているのは「簡単な単語を処理しているから」ではなく、もっと根本的な推論のダイナミクスそのものが似ているからだと言えます。

コンテキスト長ごとの比較結果です。入力する単語数が増えるほど、AIの処理プロセスは人間の脳の動きに近づいていきます。

AIは「ブラックボックス」から「理解可能なパートナー」へ

今回の研究結果はAIと人間の脳が「部分的な収束進化」を遂げていることを示しています。鳥とコウモリが異なる進化の過程を経て、空を飛ぶために似たような「翼」という構造を獲得したように、シリコン上のニューラルネットワークと生物学的脳は、言語を処理するという目的のために、最適な計算パスとして似たようなルートを辿っているのかもしれません。

もちろん、課題は残されています。今回の研究で使用されたMEGは時間分解能には優れていますが、脳の深部の活動を捉える空間分解能には限界があります。また、参加者が3名という少人数であった点も、今後の検証が必要です。しかし、22種類もの多様なモデルで一貫した傾向が見られたこと、そしてサイズとコンテキストという変数が脳との類似性をコントロールできることを示した点は、AIの内部動作を解明する上で大きな前進といえます。

AIは長らく「ブラックボックス」と呼ばれ、その判断プロセスが人間に理解不能であることが不安の種となってきました。しかし、この研究が示すように、AIが進化し、文脈を深く理解するようになればなるほど、その思考プロセスはむしろ人間に近づいていくのです。将来的に、AIと人間はより自然にコミュニケーションを取り、お互いの思考を直感的に理解し合えるようになるのかもしれません。

グラレコで解説