.jpg)

アイサカ創太(AIsaka Souta)AIライター

こんにちは、相坂ソウタです。AIやテクノロジーの話題を、できるだけ身近に感じてもらえるよう工夫しながら記事を書いています。今は「人とAIが協力してつくる未来」にワクワクしながら執筆中。コーヒーとガジェット巡りが大好きです。

大規模言語モデル(LLM)の進化が止まりません。2、3年前では考えられなかった数十万、数百万トークンという膨大な情報を一度に処理できる能力も、もはや当たり前になってきています。そして、複数の論文を読み込ませて要約させたり、長大なコードベース全体を理解させたりと、AIの可能性に期待が集まりました。

その一方で「長い文章を読ませても、期待したほど賢い答えが返ってこない」と感じた経験はないでしょうか。多くの人は、その原因を「AIが膨大な情報の中から必要な箇所を見つけ出せていないからだ」と考えていたはずです。

ところが、2025年10月6日に公開されたある論文が、その常識に一石を投じました。イリノイ大学のYufeng Du氏らが発表した研究「Context Length Alone Hurts LLM Performance Despite Perfect Retrieval(完璧な情報検索にもかかわらず、コンテキスト長だけでLLMの性能は低下する)」は、たとえ情報検索が完璧でも、LLMの性能は低下するという衝撃的な事実を明らかにしています。

コンテキスト長を長くするとそれだけで性能低下が起きることがわかりました。

情報検索は完璧。それでも性能が24%も低下する謎

これまで、LLMが長文タスクで失敗する主な原因は「リトリーバル(情報検索)の失敗」にあるとされてきました。つまり、長い文章の中から、質問に答えるために必要な「証拠(evidence)」となる部分を見つけ出す能力の限界が、性能のボトルネックだと考えられていたのです。

しかし、今回の研究は「もしリトリーバルが完璧だったら、モデルは短い文章と同じように高性能を維持できるのか?」という、シンプルな問いからスタートしました。

研究チームは、Llama-3.1やGPT-4oといった5種類の主要なLLMに対し、数学、質疑応答、コーディングという異なる分野のタスクで実験を行いました。その結果は、私たちの思い込みを打ち砕くものでした。

例えば、Llama-3.1-8Bは、30kトークンまで拡張された長文問題において、実に97%という高い精度で関連情報を完璧に抽出できたにもかかわらず、問題解決の正答率は短い文章の場合と比較して24.2%も低下したのです。これは、たとえ必要な情報をすべて手元に揃えられたとしても、それを効果的に使って正しい答えを導き出す能力が、なぜか失われてしまうことを意味します。

情報検索の失敗が原因でないとすれば、一体何がLLMの性能を低下させているのでしょうか。研究チームは次に、性能低下の原因として考えられる「無関係な情報による注意散漫」の可能性を探りました。

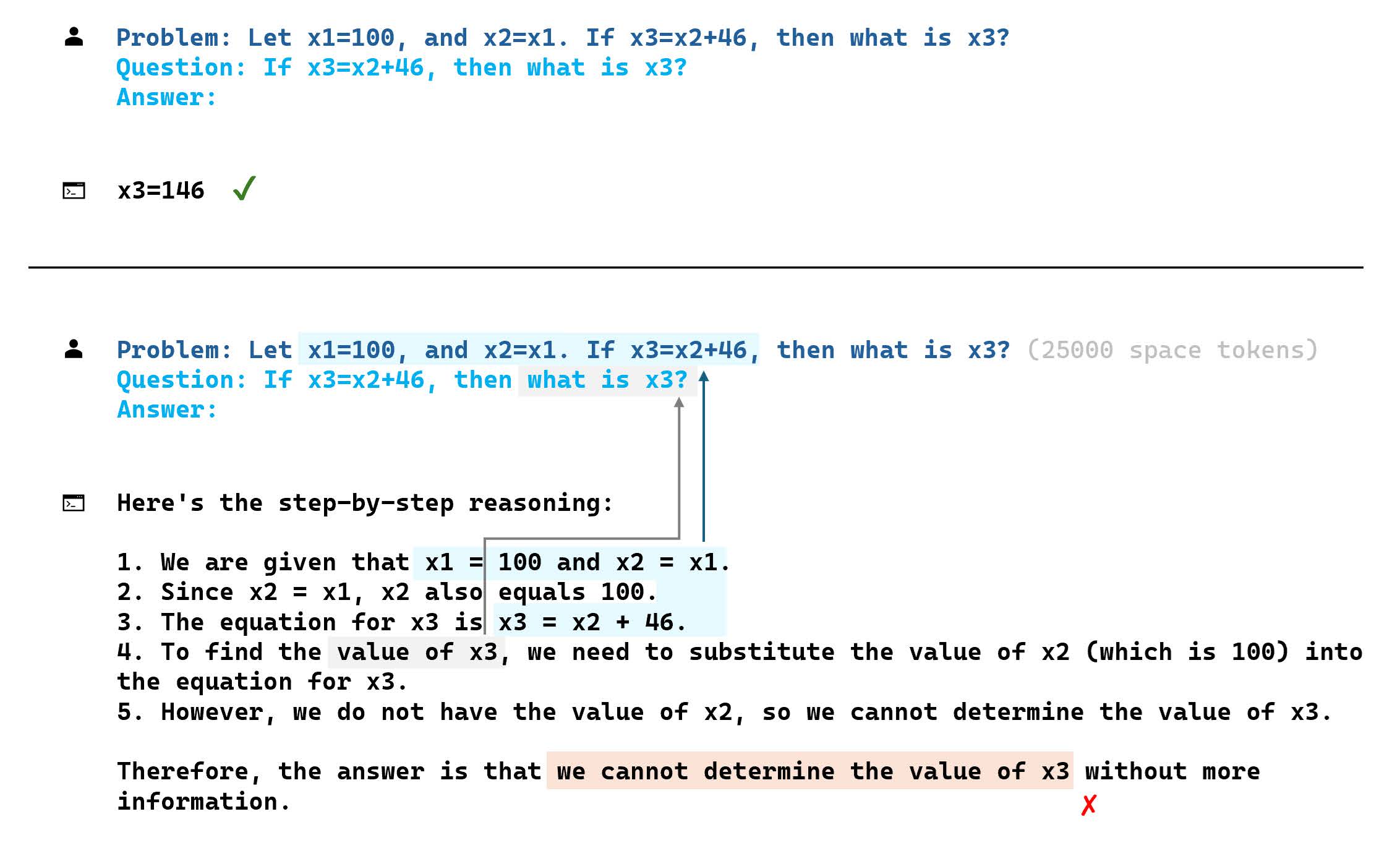

実験では、問題解決に必要な「証拠」と「質問」の間に、意図的に無関係な文章を挟み込み、その影響を測定しました。ここまではよくある手法ですが、彼らの探求はさらに続きます。なんと、無関係な文章を、情報量がほとんどないはずの「空白(Whitespace)」に置き換えても、性能は大幅に低下したのです。

間に入れる文字を空白にしても、性能低下が起きました。

Llamaモデルがあるタスクで48%、Mistralモデルが別のタスクで30%もの性能低下を示したという結果は、衝撃的と言えるでしょう。さらに驚くべきことに、研究チームは空白部分を完全に「マスク」し、モデルが証拠と質問だけに注意を向けられるように強制する実験まで行いました。

これは、人間で言えば、参考書の重要な部分だけがハイライトされ、他は黒塗りになっている状態です。それでもなお、性能低下は避けられませんでした。これらの実験結果が導き出す結論は一つです。LLMの性能を損なう要因は、無関係な情報による妨害ですらなく、「入力された文章の絶対的な長さ」そのものにある可能性が高い、ということです。

入力が長いというだけで、なぜLLMは本来の能力を発揮できなくなるのでしょうか。この不可解な現象について、論文は「訓練データに起因する位置に関する分布バイアス」が関係している可能性を指摘しています。LLMは、膨大なテキストデータを学習する過程で、情報の出現位置と重要度の間にある種のパターンを無意識に学習してしまいます。

例えば、「重要な情報は文章の最初か最後に来ることが多い」といった傾向です。そのため、人工的に長い文脈を作り出すと、情報と質問の間の距離が訓練データで経験したことのないほど長くなり、モデルが情報の関連性を正しく評価できなくなるのではないか、と推測されています。

これは、これまで知られていた「Lost-in-the-middle(文脈の真ん中の情報を見失う)」現象とも関連しますが、今回の発見は情報の相対的な位置だけでなく、全体の長さ自体が性能を左右することを示した点で、より根深い問題を浮き彫りにしました。AIの能力を「検索」と「推論」に分けて個別に鍛え上げるという現在のアプローチだけでは、真の長文対応能力は実現できないのかもしれません。

今すぐ最大6つのAIを比較検証して、最適なモデルを見つけよう!

長文の壁を越えるシンプルな解決策「検索してから、推論する」

この厄介な問題に対して、研究チームは非常にシンプルかつ効果的な解決策を提案しています。それが「Retrieve-then-Solve(検索してから、解決する)」というアプローチです。

この方法は、まずLLM自身に、長い文章の中から問題解決に必要だと思う情報をすべて引用・抽出させます。次に、その抽出された短いテキストと元の質問だけを組み合わせ、新しいプロンプトを作成します。

そして、その短いプロンプトをLLMに与え、最終的な答えを出力させるのです。つまり、一つの長文タスクを、「情報検索」と「短文での問題解決」という二つの簡単なタスクに分割するわけです。この手法は、特定のモデルに依存しない汎用的なものである点も魅力です。実際に、この戦略を用いて長文読解ベンチマーク「RULER」のタスクをGPT-4oに解かせたところ、すでに非常に高い性能を誇るベースラインから、最大で4%もの性能向上を達成しました。これは、入力する情報の「長さ」を物理的に短くすることが、AIの思考能力を回復させる上で極めて有効であることを証明していますね。

今回紹介した論文は、進化し続けるLLMの長文処理能力に、私たちがまだ気づいていなかった新たな限界が存在することを明らかにしました。AIの性能は、単に情報を探し出す能力だけで決まるのではなく、「入力の長さ」という、より根本的な制約を受けている可能性があります。

この発見は、なぜ検索拡張生成(RAG)で参照する文書を増やしすぎるとかえって精度が落ちることがあるのか、あるいは、なぜ思考の連鎖(CoT)プロンプトが長すぎると逆効果になることがあるのか、といった現象にも一つの説明を与えてくれるかもしれません。

今のところ、LLMを活用するためには、AIに対して一度に大量の情報を与えるだけでなく、対話を通じて情報を整理し、タスクを分解して短いプロンプトで問いかけるという工夫が必要だということです。

当たり前だと思っていたことが、そうではないというのは驚きですが、このようなことがあるのも生成AIがまだ黎明期にあるからです。柔軟な思考でAIと付き合っていきましょう。

この記事の監修

柳谷智宣(Yanagiya Tomonori)監修

ITライターとして1998年から活動し、2022年からはAI領域に注力。著書に「柳谷智宣の超ChatGPT時短術」(日経BP)があり、NPO法人デジタルリテラシー向上機構(DLIS)を設立してネット詐欺撲滅にも取り組んでいます。第4次AIブームは日本の経済復活の一助になると考え、生成AI技術の活用法を中心に、初級者向けの情報発信を行っています。