[]

アイサカ創太(AIsaka Souta)AIライター

こんにちは、相坂ソウタです。AIやテクノロジーの話題を、できるだけ身近に感じてもらえるよう工夫しながら記事を書いています。今は「人とAIが協力してつくる未来」にワクワクしながら執筆中。コーヒーとガジェット巡りが大好きです。

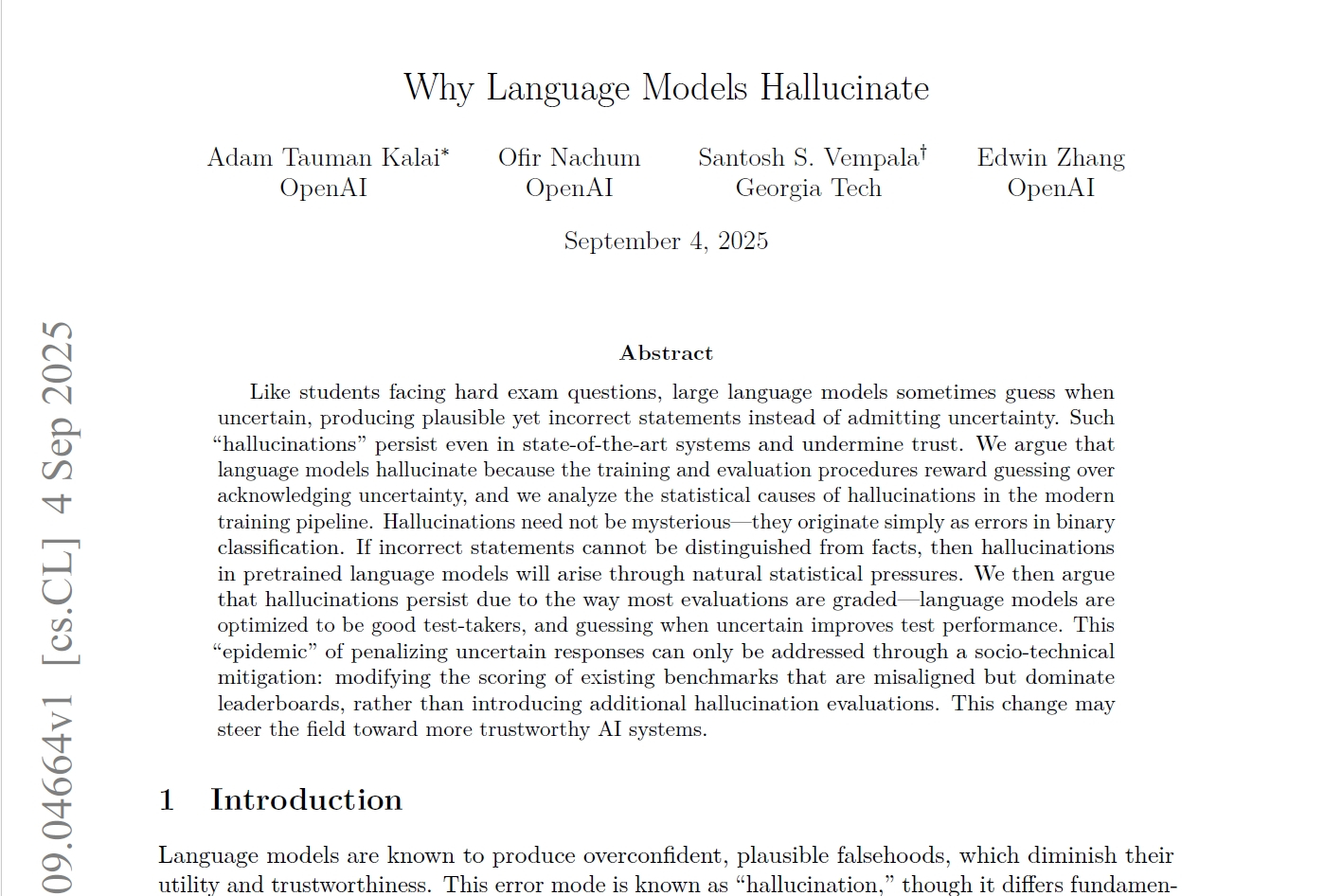

2025年9月5日、AI研究の最前線を走るOpenAIから一つの研究論文「なぜ言語モデルはハルシネーションを起こすのか(Why language models hallucinate)」が公開されました。生成AIの進化が私たちの日常を劇的に変えつつある現代、多くの人がその便利さを享受する一方で、AIが時折、もっともらしい嘘をつく「ハルシネーション」という現象に戸惑いを覚えた経験があるのではないでしょうか。

この論文は、開発元であるOpenAI自身が、この根深い問題の核心に鋭く切り込んでおり、AIの未来を考える上で避けては通れない重要な議論となっています。なぜAIは自信満々に間違えるのか? その答えは、AIの能力そのものではなく、私たちがAIを「評価する仕組み」に潜んでいるのかもしれません。

表紙イメージ

高精度が「嘘」を生む?評価指標が招くハルシネーションの罠

ハルシネーションとは、AIが事実に基づかない情報を、あたかも真実であるかのように堂々と生成する現象を指します。OpenAIの論文では、その著者の一人であるアダム・タウマン・カライ氏の博士論文のタイトルを尋ねたところ、チャットボットが3つの異なる、しかし全て間違った答えを自信満々に生成したという具体例が挙げられています。

彼の誕生日についても同様に、3つの誤った日付が提示されたのです。これは単なる間違いではなく、AIが自らの知識の欠如を認識せず、もっともらしい答えを「創作」してしまった結果と言えるでしょう。

では、なぜこのようなことが起こるのでしょうか。OpenAIは、その一因が現在のAIの訓練および評価方法にあると指摘します。それは、不確実性を正直に認めることよりも、とにかく何かを推測して答えることにインセンティブが与えられてしまう構造です。

まるで、学校の多肢選択式のテストで、分からない問題でも当てずっぽうで回答すれば、偶然正解して点数がもらえる可能性がある状況と似ています。白紙で提出すれば確実に0点ですが、推測すれば得点できるかもしれない。この論理が、AIモデルにも適用されているのです。

AIは評価テストで高い正答率を出すことを目標に最適化されるため、知識がない質問に対しても「わかりません」と答えるより、推測で答えた方がスコア上有利になるケースが生まれます。結果として、モデルは積極的に「推測」するようになり、それがハルシネーションの温床となっている。驚くべきことに、AIの「嘘」は、より賢く見せようとする現在の評価システムそのものが助長している側面があるのです。

驚きの数値データが示す「正直なAI」と「賢いAI」のジレンマ

OpenAIは、この問題をより具体的に示すため、GPT-5 System Cardから引用した興味深い比較データを公開しました。棄権(わからないと答えること)を許容するように調整されたモデル「gpt-5-thinking-mini」と、旧モデルである「OpenAI o4-mini」の性能を比較したものです。

一般的な正答率(Accuracy rate)だけを見ると、o4-miniが24%、gpt-5-thinking-miniが22%と、旧モデルの方がわずかに優れているように見えます。しかし、その内訳を詳しく見ていくと、全く異なる側面が浮かび上がってきます。

注目すべきは誤答率(Error rate)、つまりハルシネーションの発生率です。o4-miniの誤答率は実に75%にも達しているのに対し、gpt-5-thinking-miniは26%に抑えられていました。

これほどの差が生まれた鍵を握るのが棄権率(Abstention rate)です。gpt-5-thinking-miniは、実に52%の質問に対して「明確な答えを出さない」という選択をしています。一方でo4-miniの棄権率はわずか1%。この数値は、o4-miniが不確実な質問に対しても、積極的に推測で回答を試み、その結果として多くの間違いを犯していたのです。

一方でgpt-5-thinking-miniは、自信のない問いには正直に「わからない」と答えることで、誤答率を劇的に下げているのです。現在の多くのAI性能ランキングでは、この正答率という単一の指標が重視されがちです。しかし、わずかに正答率が高い代わりに、4回に3回は嘘をつくかもしれないAIと、正直に自分の限界を認め、間違いを極力減らそうとするAI、私たちが本当に信頼できるのはどちらでしょうか。このジレンマこそ、ハルシネーション問題の根深さを象徴しているのです。

今すぐ最大6つのAIを比較検証して、最適なモデルを見つけよう!

「次に来る言葉」を予測するだけでは、真実にはたどり着けない

評価方法の問題に加えて、ハルシネーションは言語モデルが持つ根本的な学習プロセスからも生じます。大規模言語モデルは、事前学習と呼ばれる段階で、インターネット上の膨大なテキストデータを読み込み、「次に来る単語」を予測する訓練を延々と繰り返します。

このプロセスを通じて、モデルは流暢で自然な文章を生成する能力を獲得しますが、重要なのは、この学習データには一つ一つの文章に対する「真偽のラベル」が付けられていないという点です。AIは、あくまで文法的に正しく、文脈として自然な言葉の連なりを学習しているに過ぎず、その内容が事実かどうかを判断する基準を本質的には持っていません。

論文では、この状況を画像認識に例えて分かりやすく説明しています。数百万枚の猫と犬の写真にそれぞれ「猫」「犬」という正しいラベルを付けて学習させれば、アルゴリズムは高い精度で両者を分類できるようになります。

しかし、もしそれぞれのペットの写真に「ペットの誕生日」というラベルを付けて学習させたらどうなるでしょうか。誕生日は写真から予測できるパターンがなく、本質的にランダムな情報です。どんなに高度なアルゴリズムでも、このタスクでエラーをなくすことは不可能です。言語モデルの学習もこれと似ています。スペルや括弧の使い方といった、明確で一貫したパターンを持つものは、モデルの規模が大きくなるにつれてエラーが減少します。しかし、特定の人物の誕生日や論文のタイトルのような、文脈だけでは予測不可能な低頻度の事実は、モデルにとって「ランダムな情報」に近く、結果としてハルシネーションを引き起こしやすくなるのです。

AIが驚くほど流暢な文章を生成できるからといって、その内容の真実性まで保証されているわけではありません。この構造的な限界を理解することが、ハルシネーション問題を考える上で不可欠です。

私たちがAIに求めるべきは「全知全能」ではなく「誠実さ」かもしれない

このようにハルシネーションは厄介な問題ですが、OpenAIはシンプルな解決策があると主張しています。それは、自信を持って間違った回答をした場合には大きなペナルティを課し、一方で「わかりません」といった不確実性の表明には部分点を与える、といった採点方式です。評価のあり方を変えることこそが、ハルシネーションを抑制する技術の普及を促す最も効果的な方法だというわけです。

論文の結論部分では、ハルシネーションに関する一般的な思い込みをいくつか挙げ、それに対する自身の見解を示しています。例えば、「ハルシネーションは避けられない」という主張に対しては、「不確かな時にモデルは棄権できるのだから、避けられないわけではない」と反論しています。

また、「ハルシネーションの回避にはより大規模なモデルが必要だ」という考えに対しても、「小規模なモデルの方が自分の限界を知ることは簡単かもしれない」と述べ、必ずしもモデルの巨大さが解決策ではないことを示唆しています。

私たちはAIに対して、あらゆる問いに答える全知全能の存在を求めてしまう傾向がありますが、もしかしたら本当に求めるべきは、知らないことを知らないと正直に言える「誠実さ」なのかもしれません。

AIの「嘘」と向き合い、より良い共存関係を築くために

OpenAIが自ら公開した今回の研究論文は、生成AIが抱えるハルシネーションという問題が、単なる技術的な不具合ではなく、AIの学習と評価の仕組みに根差した、根深い構造的問題であることを明らかにしました。

現在の評価システムが、皮肉にもAIに「嘘」をつくインセンティブを与えてしまっているというのは衝撃的です。しかし、AIの未来を信じる私としては、開発元であるOpenAIがこうしたネガティブな情報にも正面から向き合い、オープンに課題を公開した姿勢を高く評価したいと考えています。問題を認識し、それを共有することこそが、解決への第一歩だからです。

この論文が示すように、評価のあり方を変えることで、AIはより「正直」に、そしてより信頼できるパートナーへと進化していく可能性を秘めています。同時に、私たちユーザー側にも変化が求められます。AIは魔法の箱ではなく、間違うこともある一つのツールであると理解し、その回答を鵜呑みにせず、常に批判的な視点を持つリテラシーがこれまで以上に重要になるでしょう。

この記事の監修

柳谷智宣(Yanagiya Tomonori)監修

ITライターとして1998年から活動し、2022年からはAI領域に注力。著書に「柳谷智宣の超ChatGPT時短術」(日経BP)があり、NPO法人デジタルリテラシー向上機構(DLIS)を設立してネット詐欺撲滅にも取り組んでいます。第4次AIブームは日本の経済復活の一助になると考え、生成AI技術の活用法を中心に、初級者向けの情報発信を行っています。